みなさま 2021/11/2 -11/3 の Microsoft Ignite は見ましたか?😋

明確に Azure Arc や Azure Stack HCI のお話がありましたね。

2021年は、ハイブリッドクラウドの観点から Azure Arc や Azure Stack HCI の啓蒙活動をしているので、Azure Stack HCI OS 21H2 もGA されたことですし、限りあるリソースの中で、Azure Stack HCI OS 21H2 を使った構築の流れを記載します。

環境情報

【物理的なマシン】

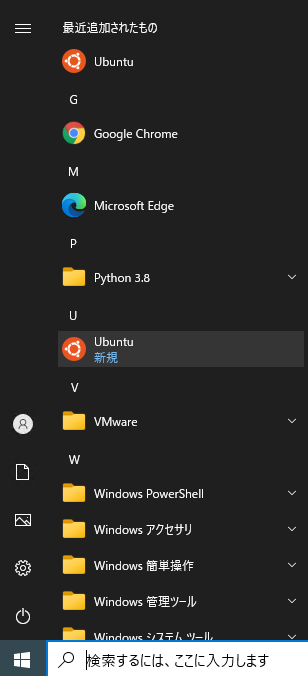

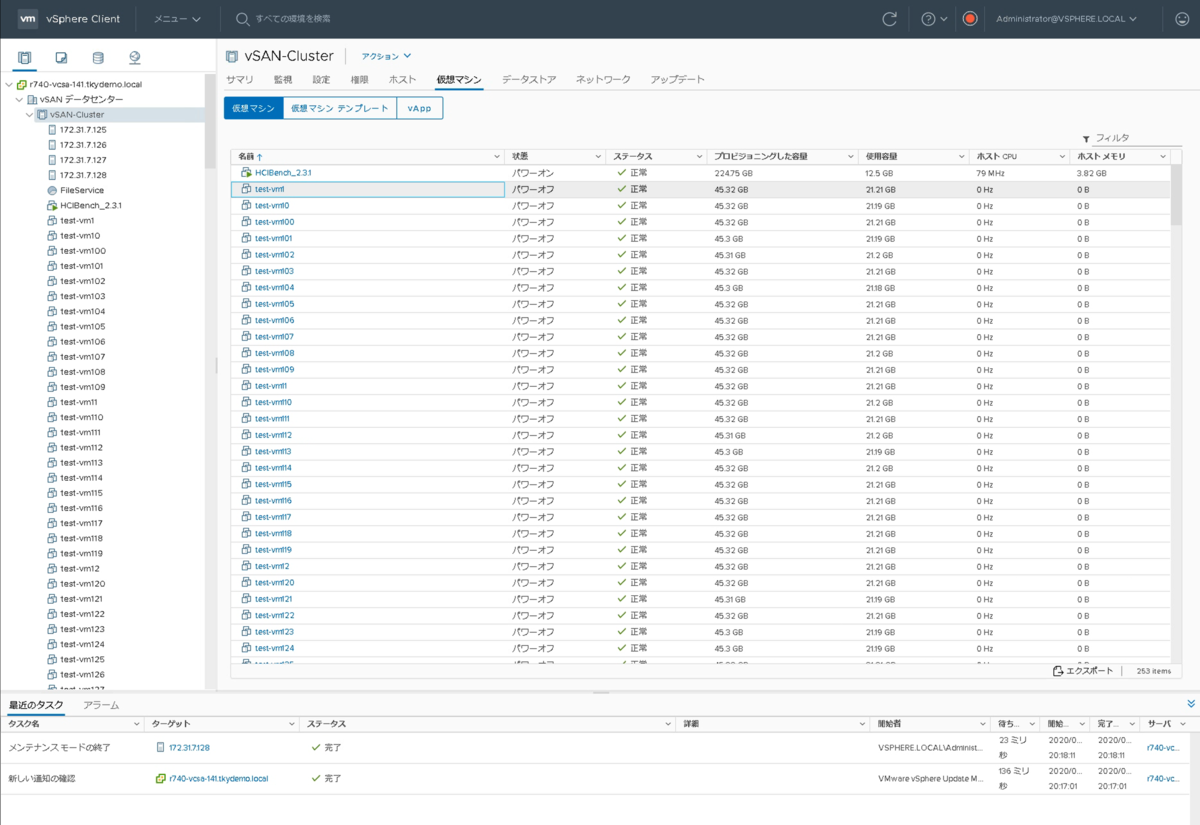

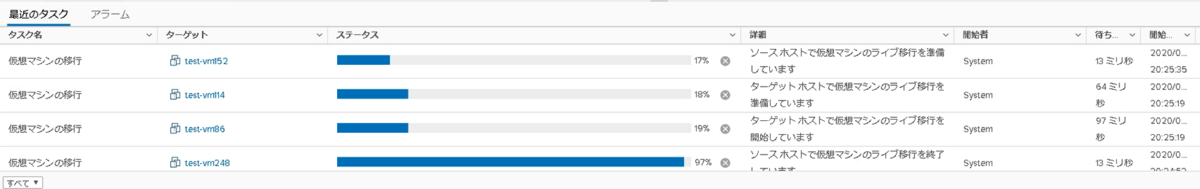

【仮想マシン】

【既に構築済のモノ】

・Active Directory / DNS は既にあるものを使っています

・Windows Admin Center は ADDS との共存は不可なので、別で立てています

【事前に見ておいたほうがいいモノ】

Azure Stack HCI攻略Wiki | Dell eカタログサイト

事前準備1

Azure Stack HCI を構築するには事前準備がすごく重要になってきます。

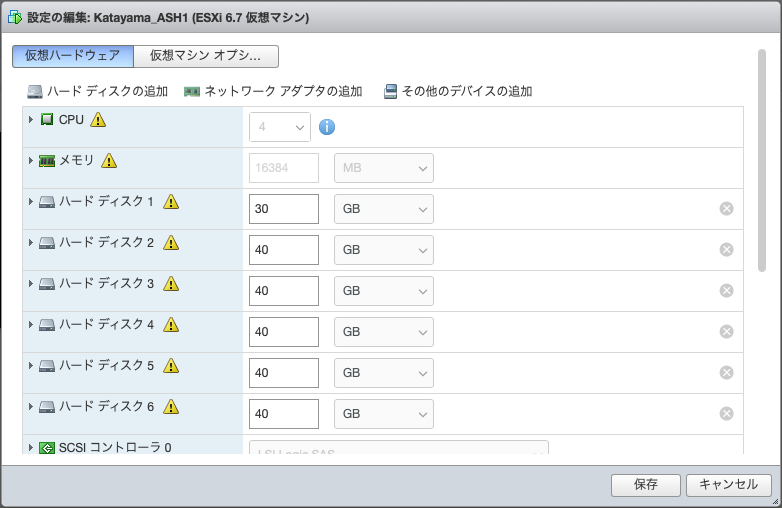

事前準備2(仮想ハードウェア)

Azure Stack HCI OS 21H2 × 3 台 を作っていきます。

すべてシンプロビジョニングです。

Azure Stack HCI OS は 現時点で All Flash が必須になっています。「自分には SSDが搭載されている!」 と錯覚させる必要があります。その方法は私のこの記事をみてほしい。

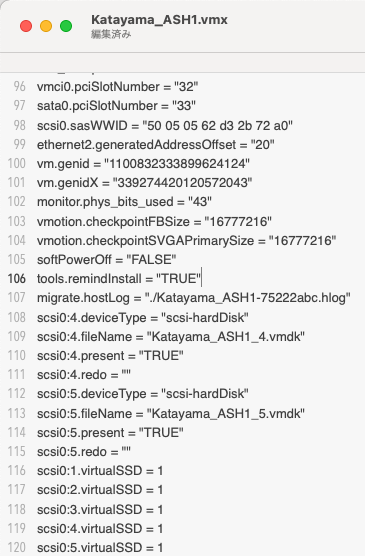

大まかに説明すると、仮想マシンの構成ファイル(.vmx)にこれを追記します。scsi0:1.virtualSSD = 1

Nested ESXiにSSDがあるように思わせる設定 - VMware / Microsoft 製品はこう使う。

今回は5つのハードディスクをSSDに思わせたいので、私はこんなカタチで追記しています。その後、パワーオンすることでSSDとしてAzure Stack HCI OS から認識されます。

scsi0:1.virtualSSD = 1 scsi0:2.virtualSSD = 1 scsi0:3.virtualSSD = 1 scsi0:4.virtualSSD = 1 scsi0:5.virtualSSD = 1

CPUの設定では [ハードウェアアシストによる仮想化をゲストOSに公開] にチェックをいれます。

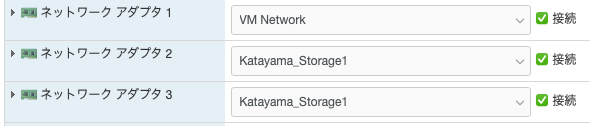

ネットワークに関しては、3本のNIC をつけています。

Azure Stack HCI OS 21H2 のインストール

OSのインストールに関しては、普通のWindows Server をインストールするときと何も差がありません。3台に同じようにインストールを実施します。

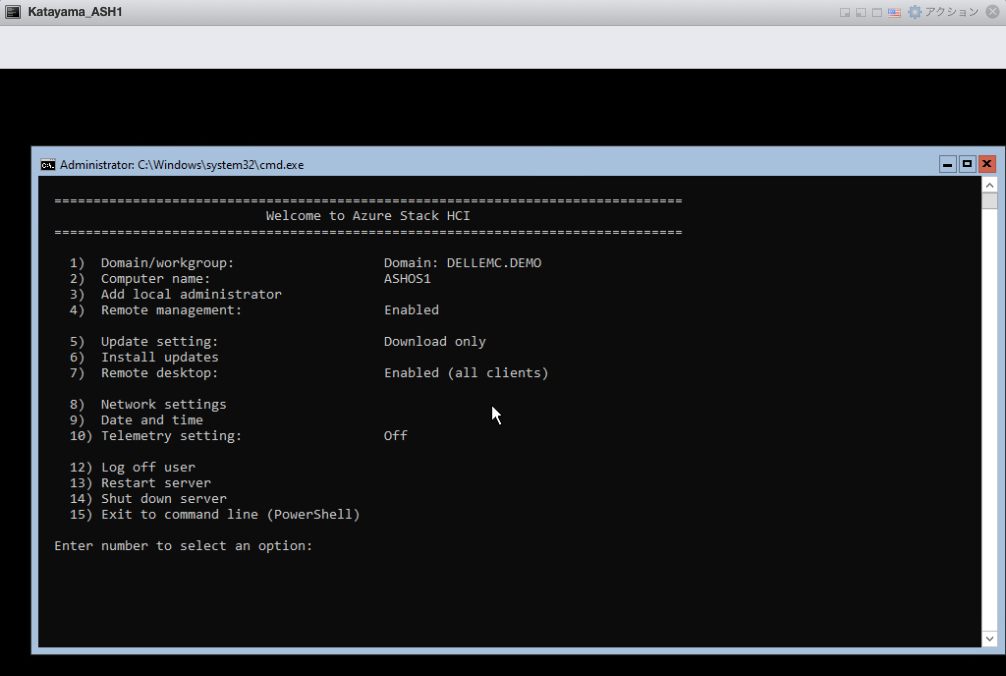

この画面で最低限実施することは、以下になります。

・IP Address の設定(管理IP, Storage IP) ・ホスト名の設定

やっておいたらいいことは以下です。

・ドメインへの参加

Azure Stack HCI OS 21H2 のIP Address の設定で私が少しハマった(困った)のは、書式 コマンド例 netsh interface ip set address "Ethernet0" static 172.16.1.101 255.255.255.0 172.16.1.1

また、この環境特有の話ではないですが、"Ethernet0" "Ethernet1" "Ethernet2" がどのネットワークに所属しているNICなのかわからなくなってしまいがちなので、そのあたりもご注意ください。

Windows Admin Center (WAC) のみで Azure Stack HCI を構築していく

これまでコマンドで構築していくのが主流の Azure Stack HCI でしたが、Windows Admin Center のみで構築をしていきます。GUI のみで構築!

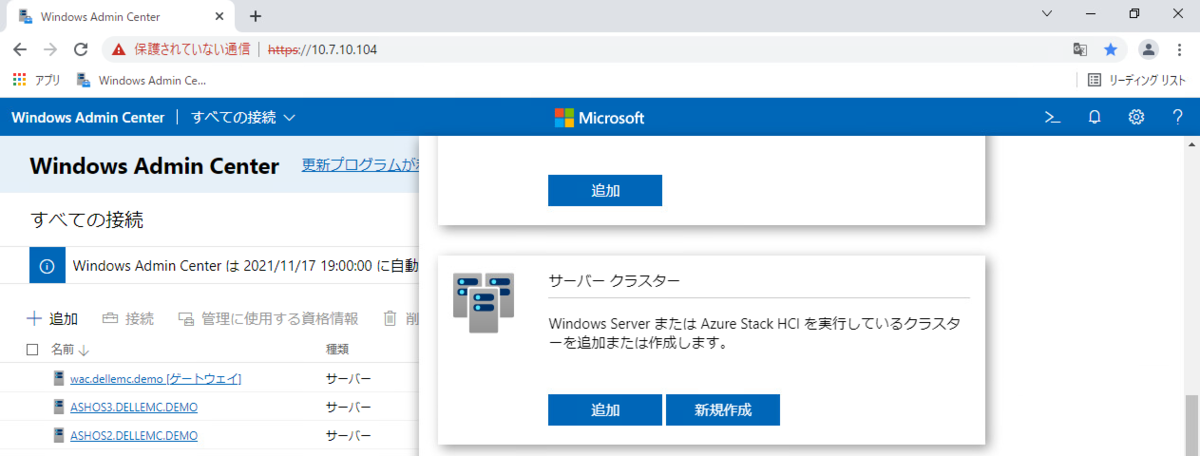

Windows Admin Center にログインし、[追加]ボタンをクリックすると、

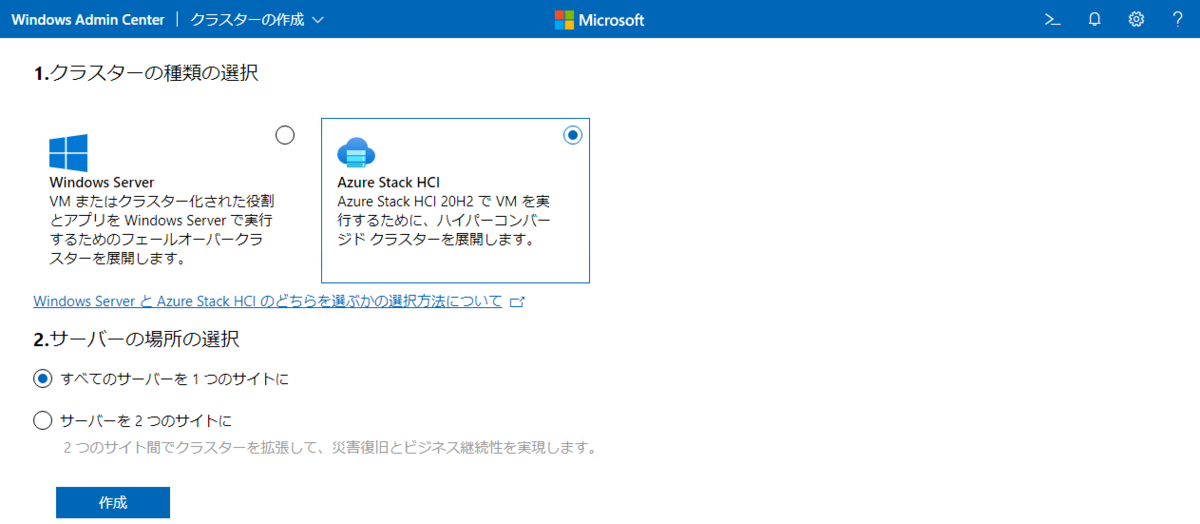

[Azure Stack HCI] を選択し、[すべてのサーバーを1つのサイトに] をクリックします。

事前にどのような前提条件があるのかを表示してくれています。

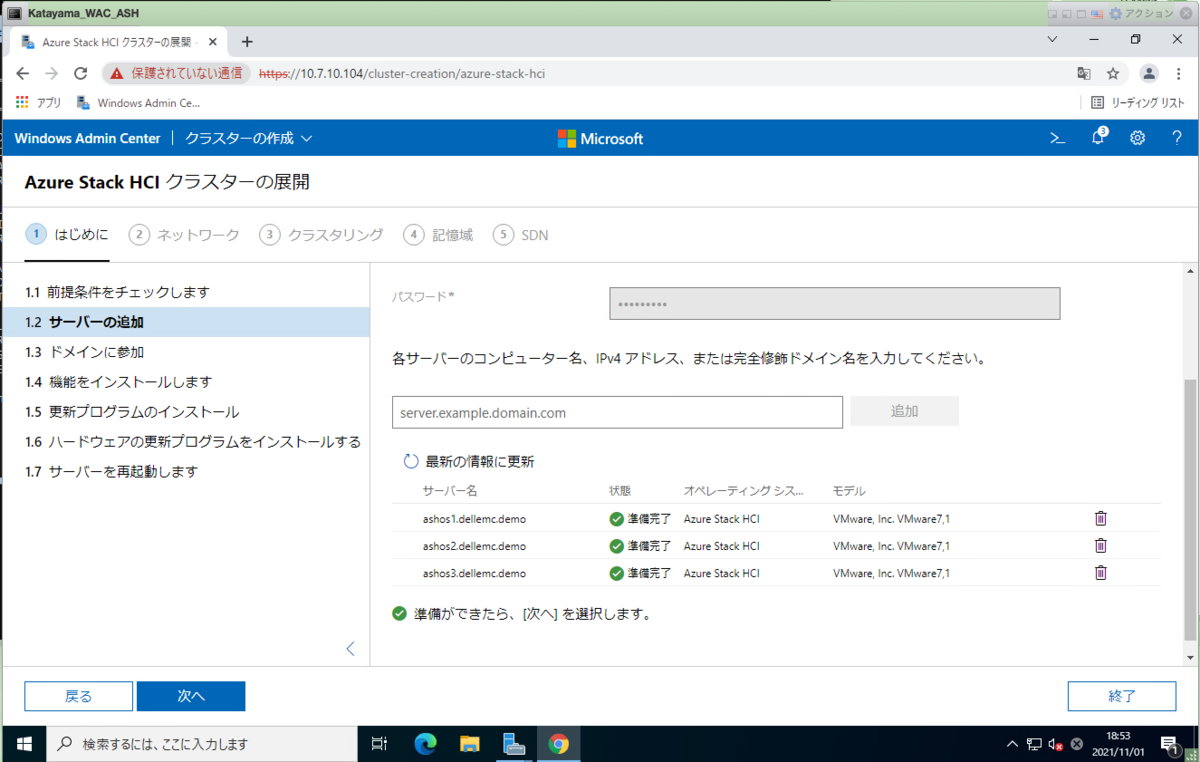

ここからが、構成していくフェーズに入ります。

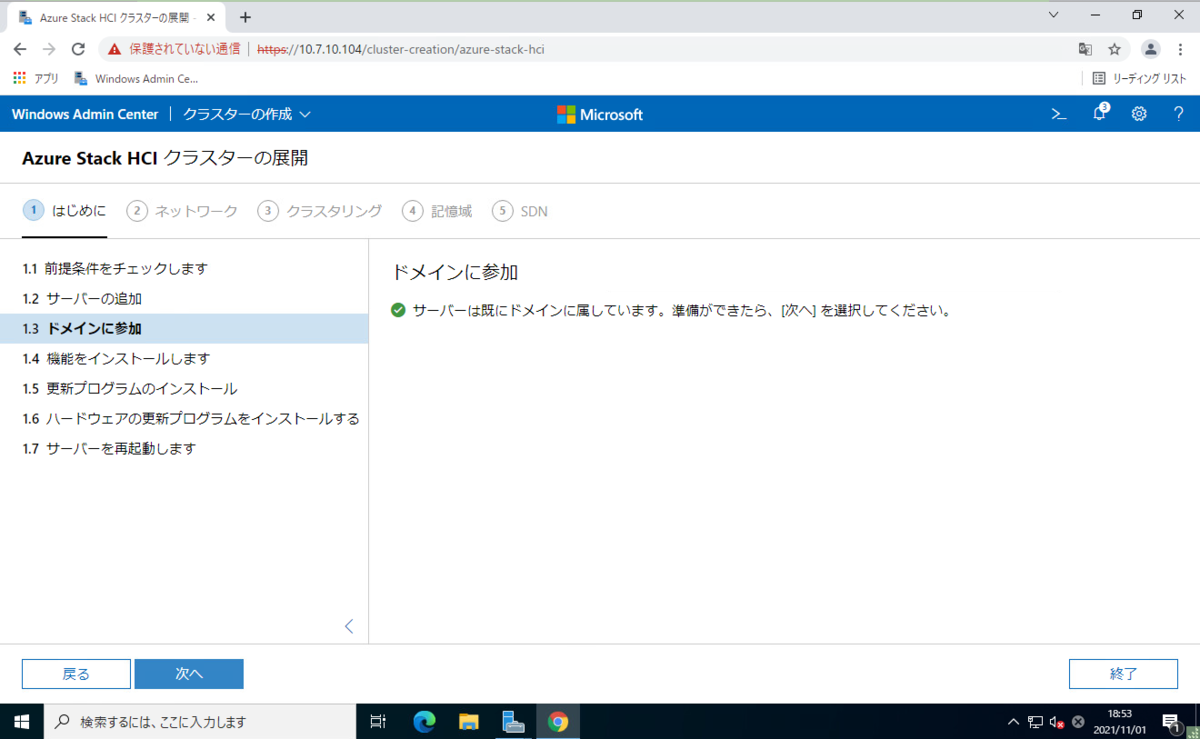

事前準備の段階でドメイン参加をしたので、ここでは既にドメインに参加済みであることが表示されています。そのまま [次へ] をクリックします。

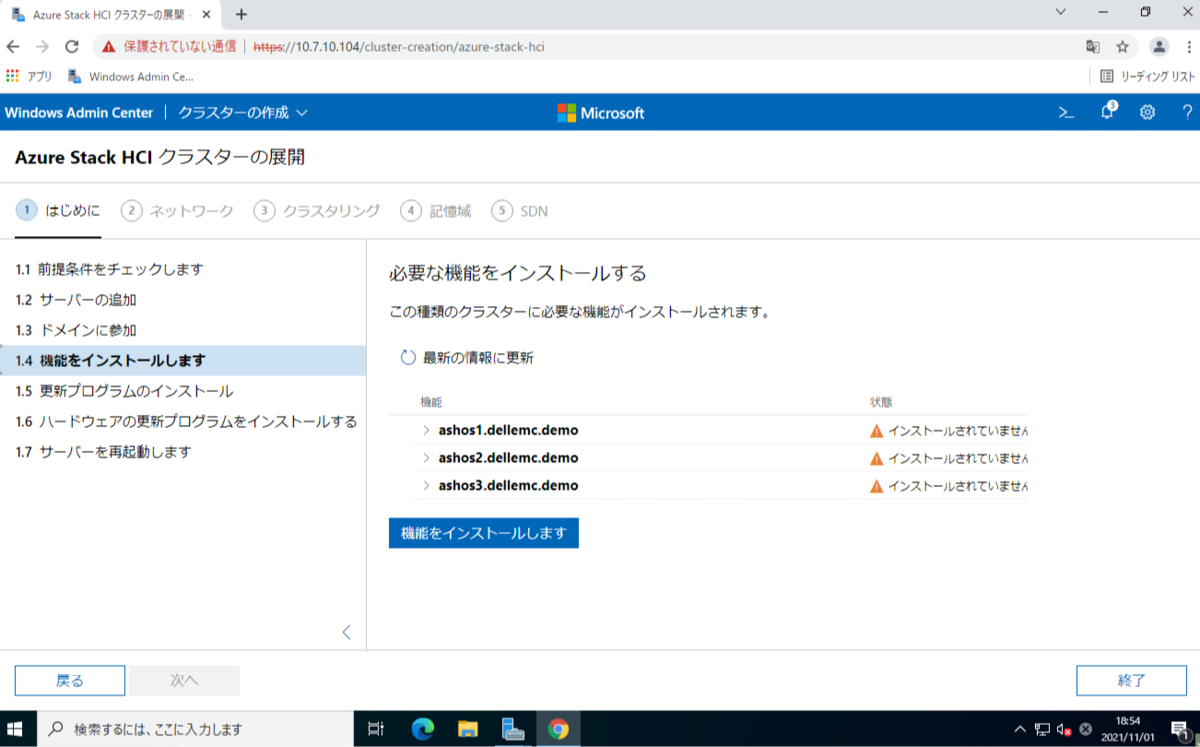

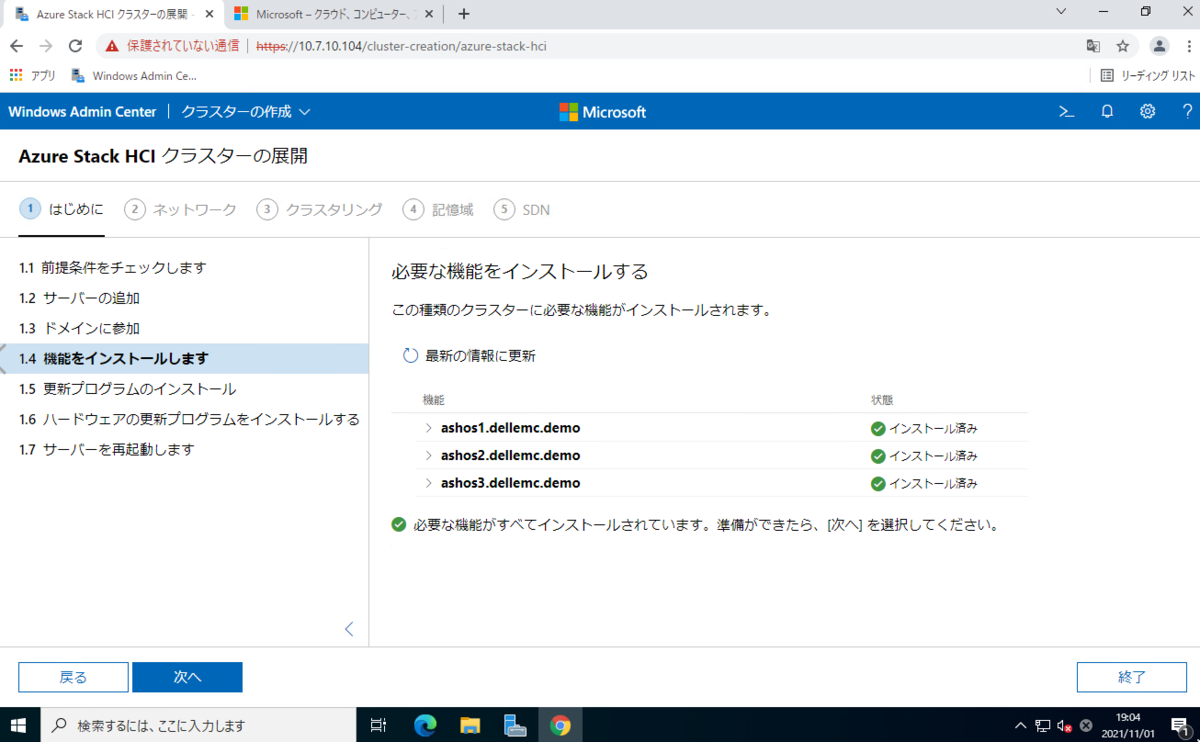

[機能をインストールします] をクリックします。

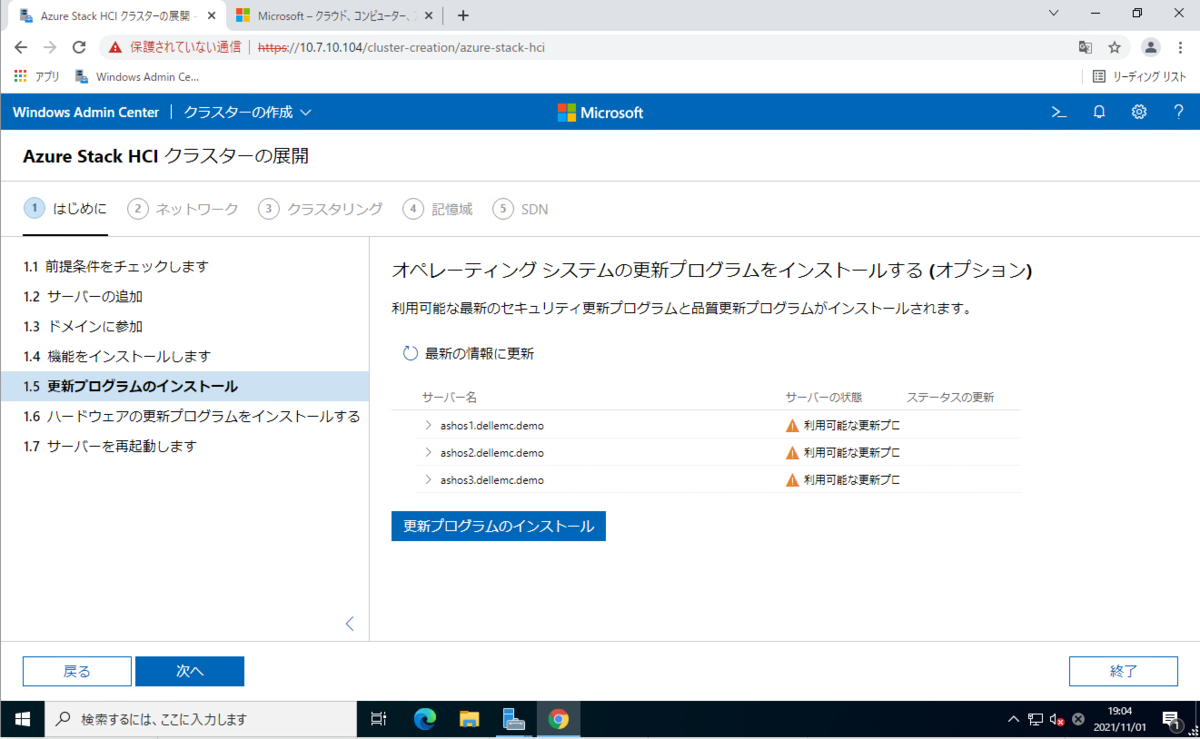

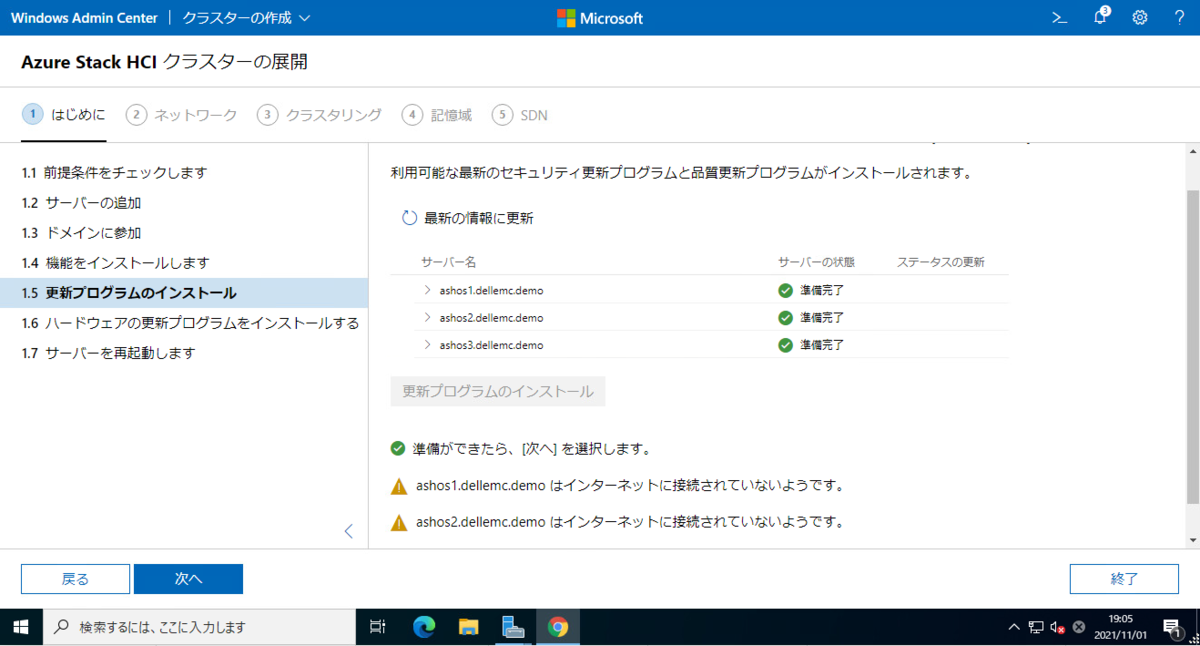

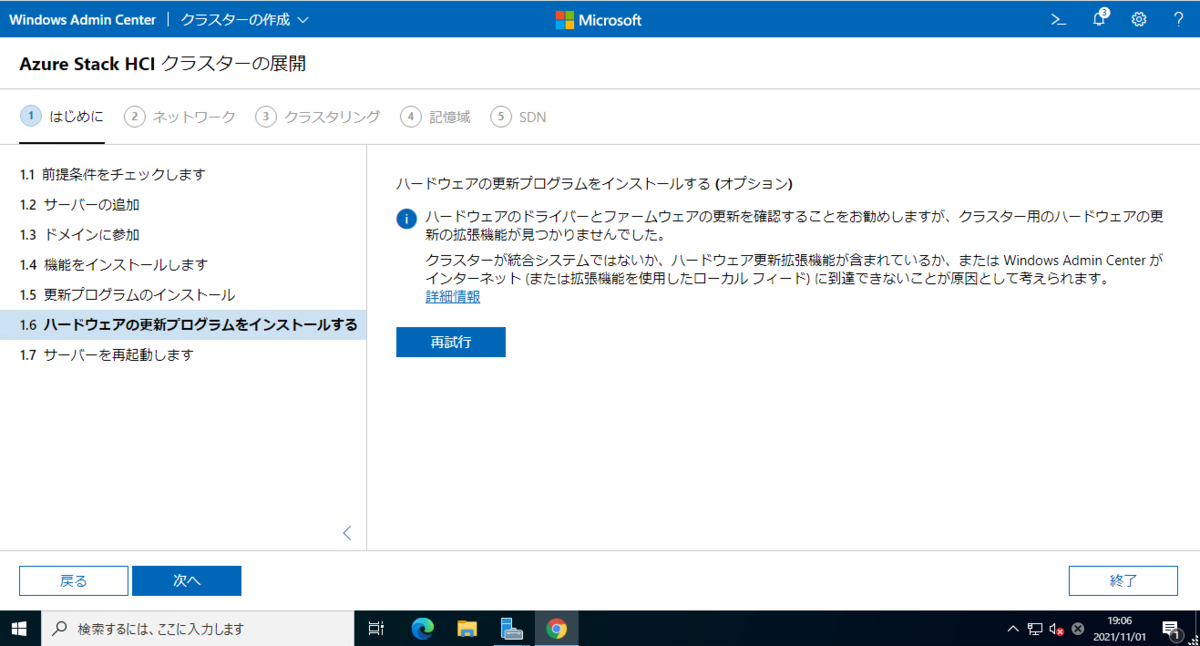

更新プログラムのインストールも流れ作業で適用可能です。

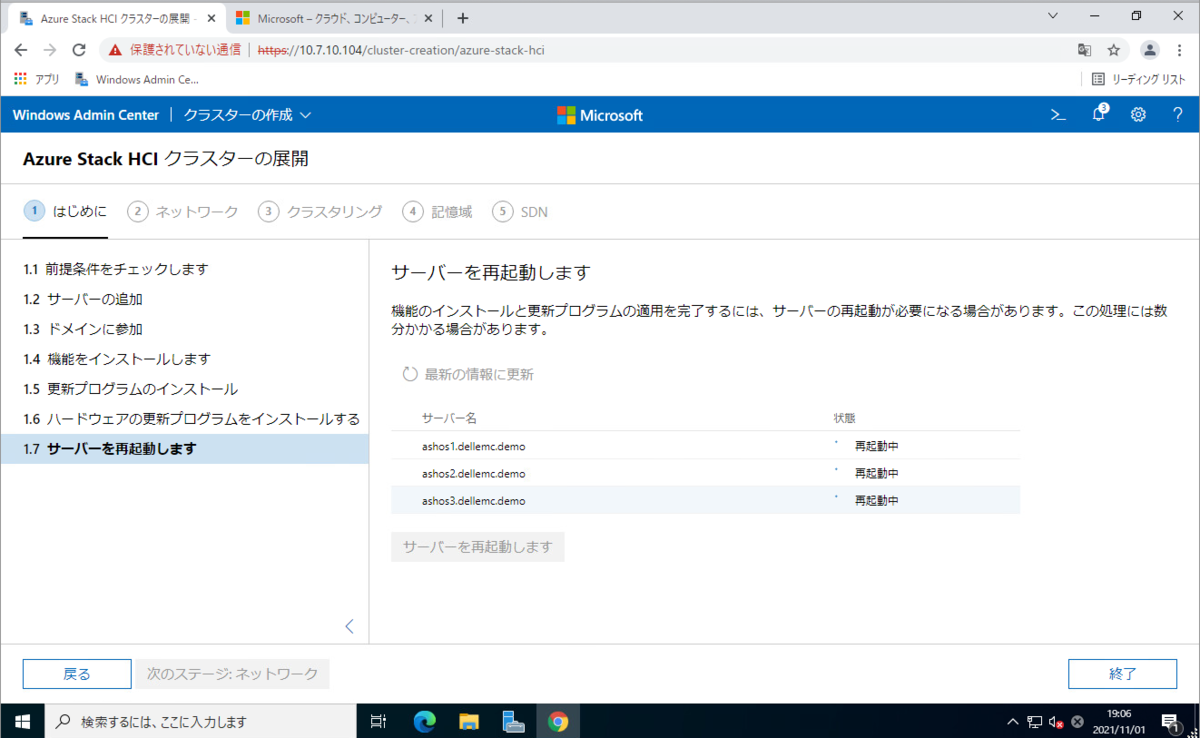

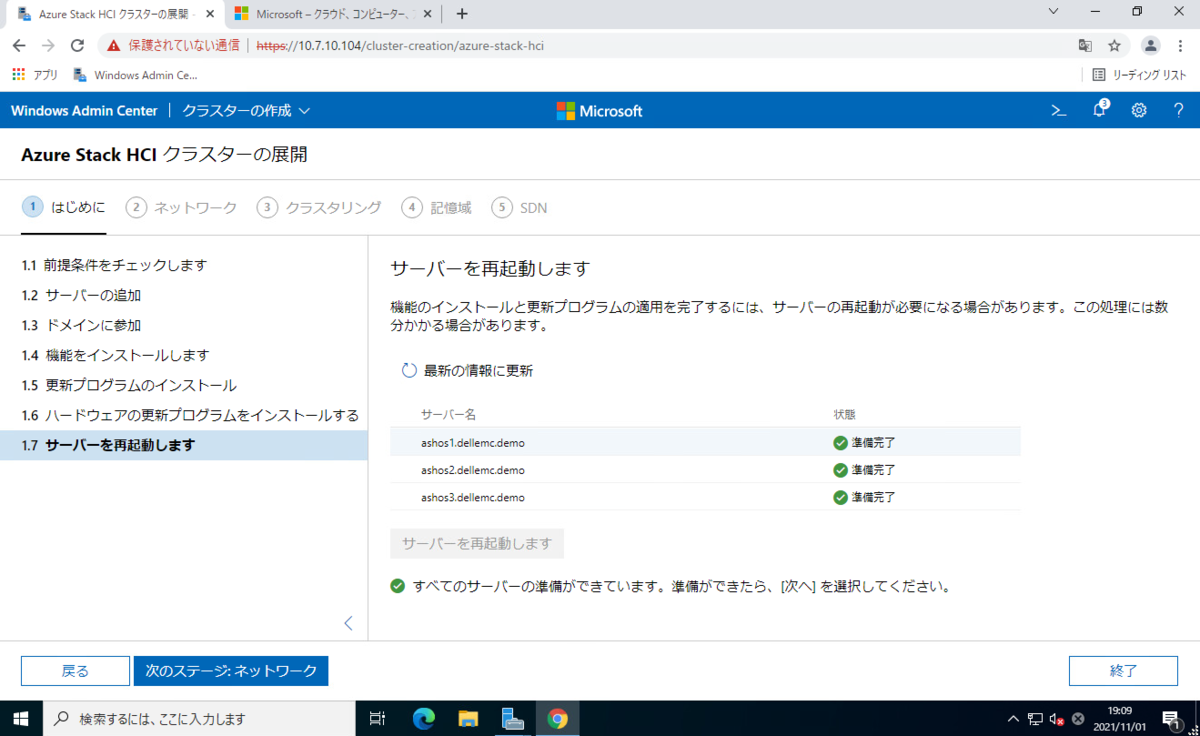

再起動を実施します。Nested のため、再起動に関しては激早いです。

再起動が終わったら、[次のステージ:ネットワーク] ボタンがクリックできるようになります。

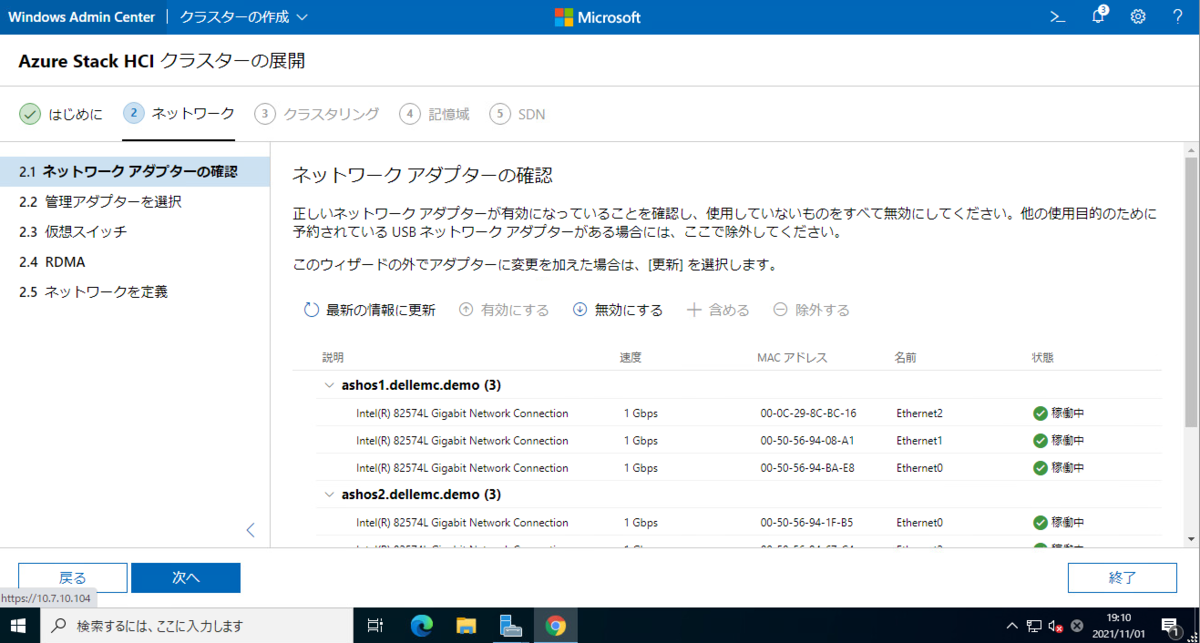

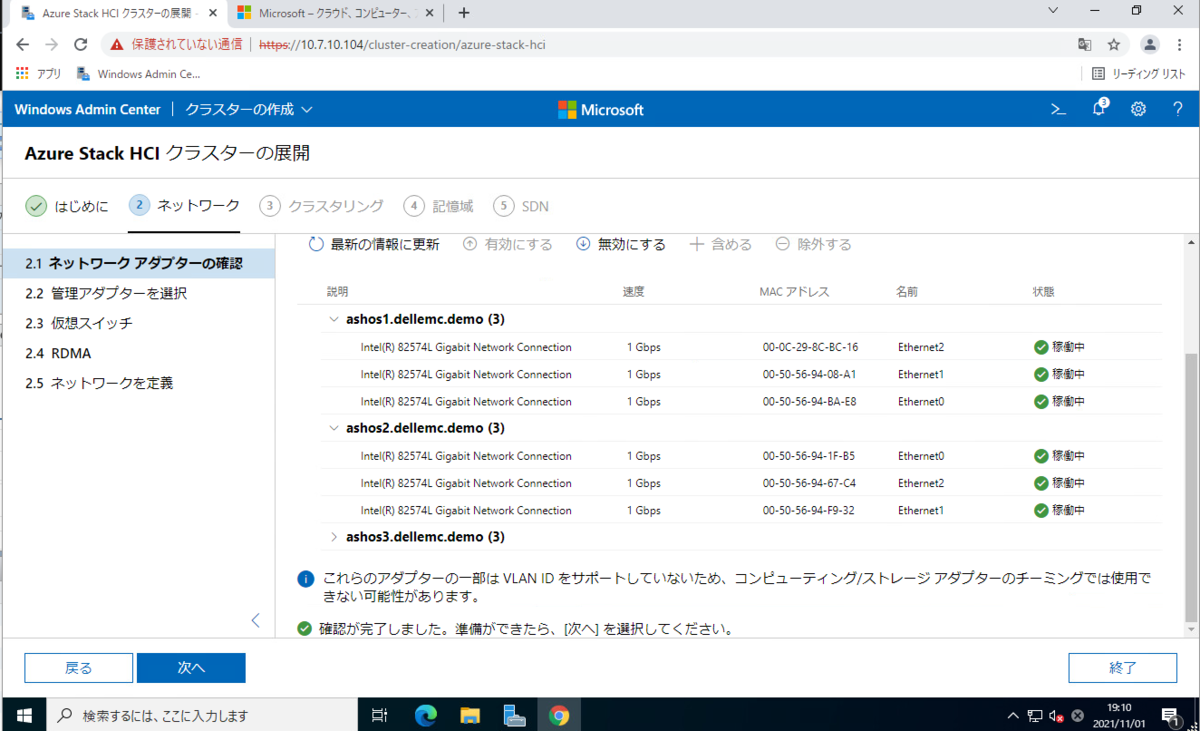

続いて、ネットワークの設定セクションに入っていきます。

すべて3つのNIC を搭載させています。

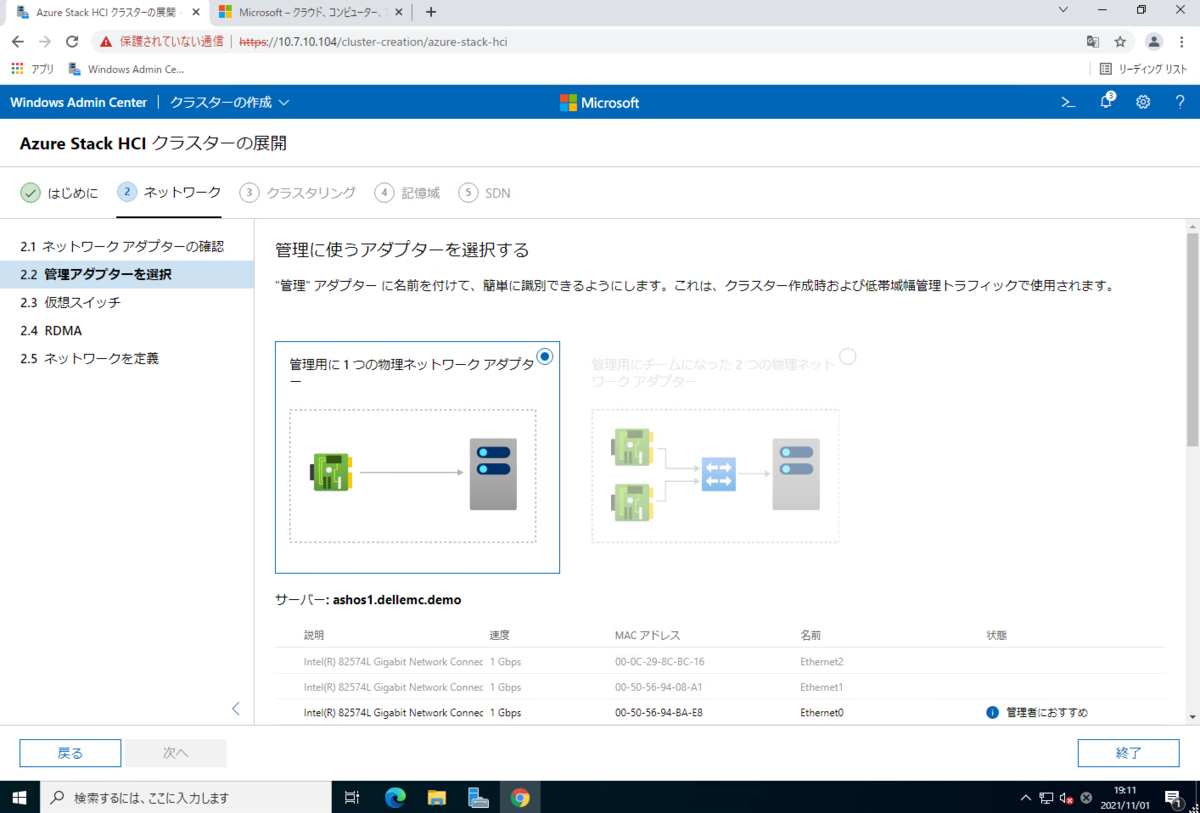

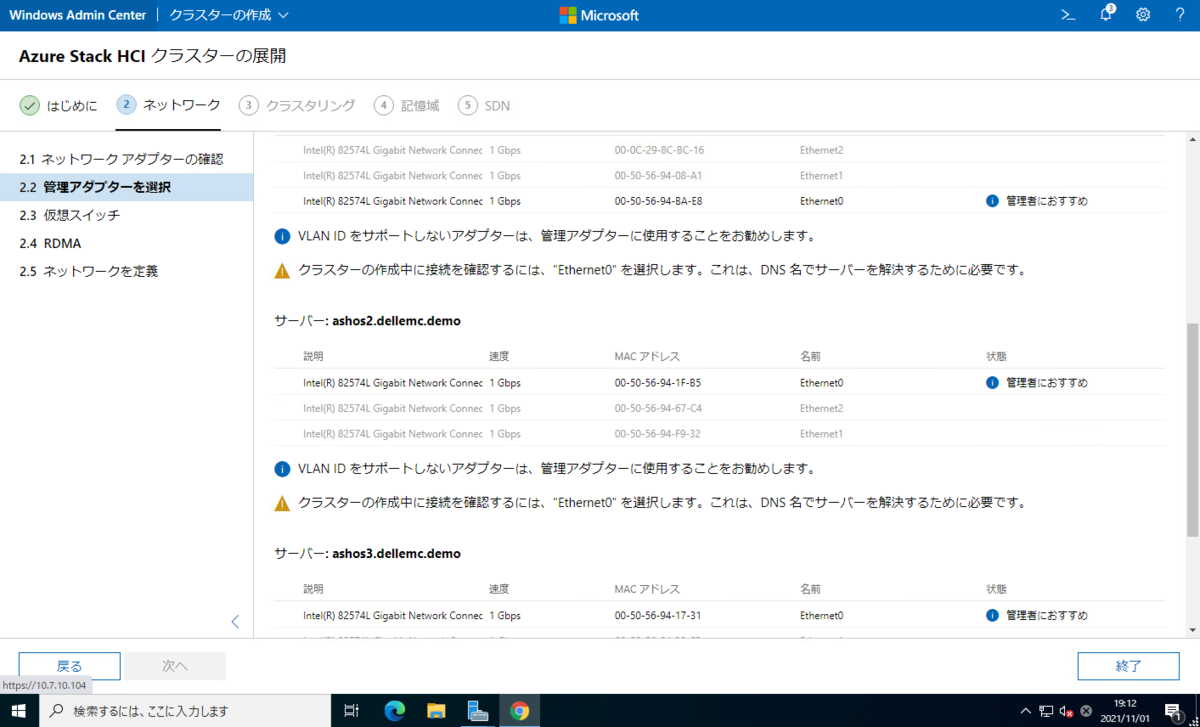

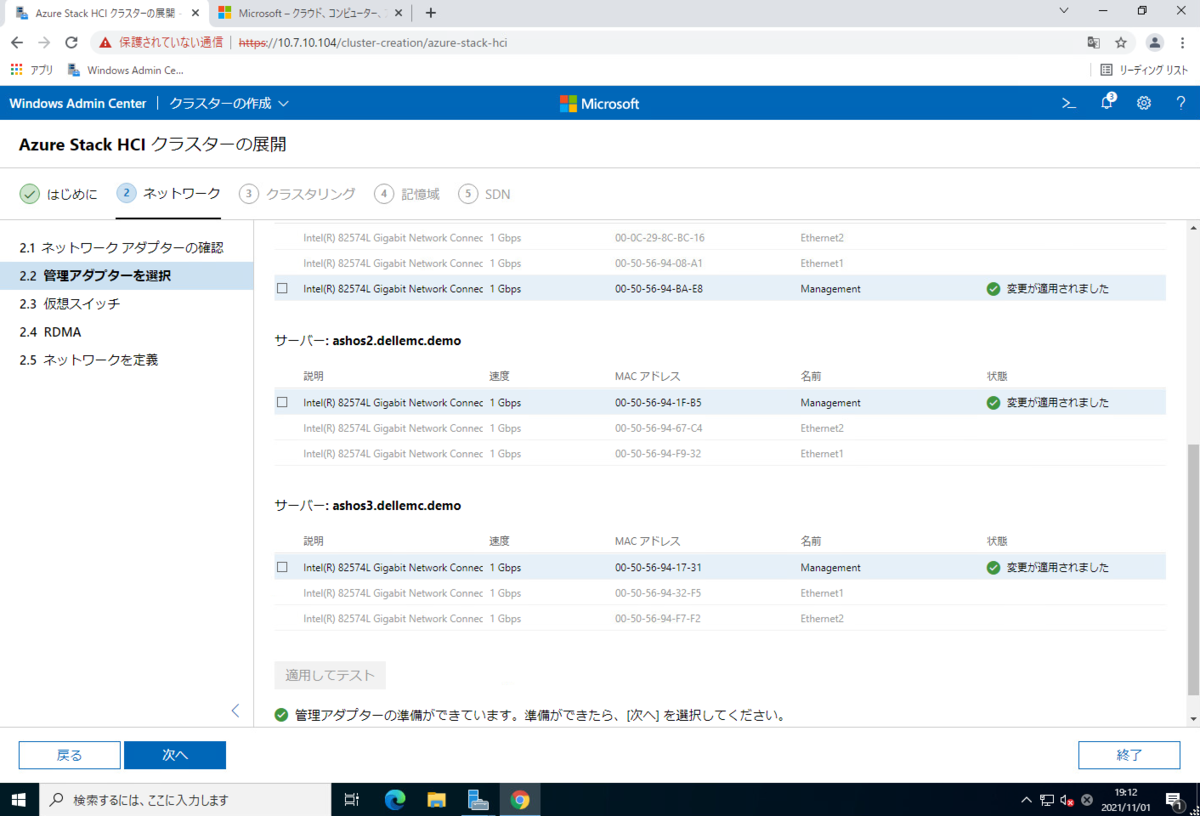

管理ネットワークで使う NIC を選びます。

事前に "Ethernet0" にのみきちんと管理ネットワークのIP Address を設定していたため、 "管理者におすすめ" と親切に記載してくれています。

[適用してテスト] ボタンをクリックすると疎通確認が行われ、[次へ]ボタンがクリックできるようになります。ここで管理ネットワークでどのNICを使うのかが決まります。

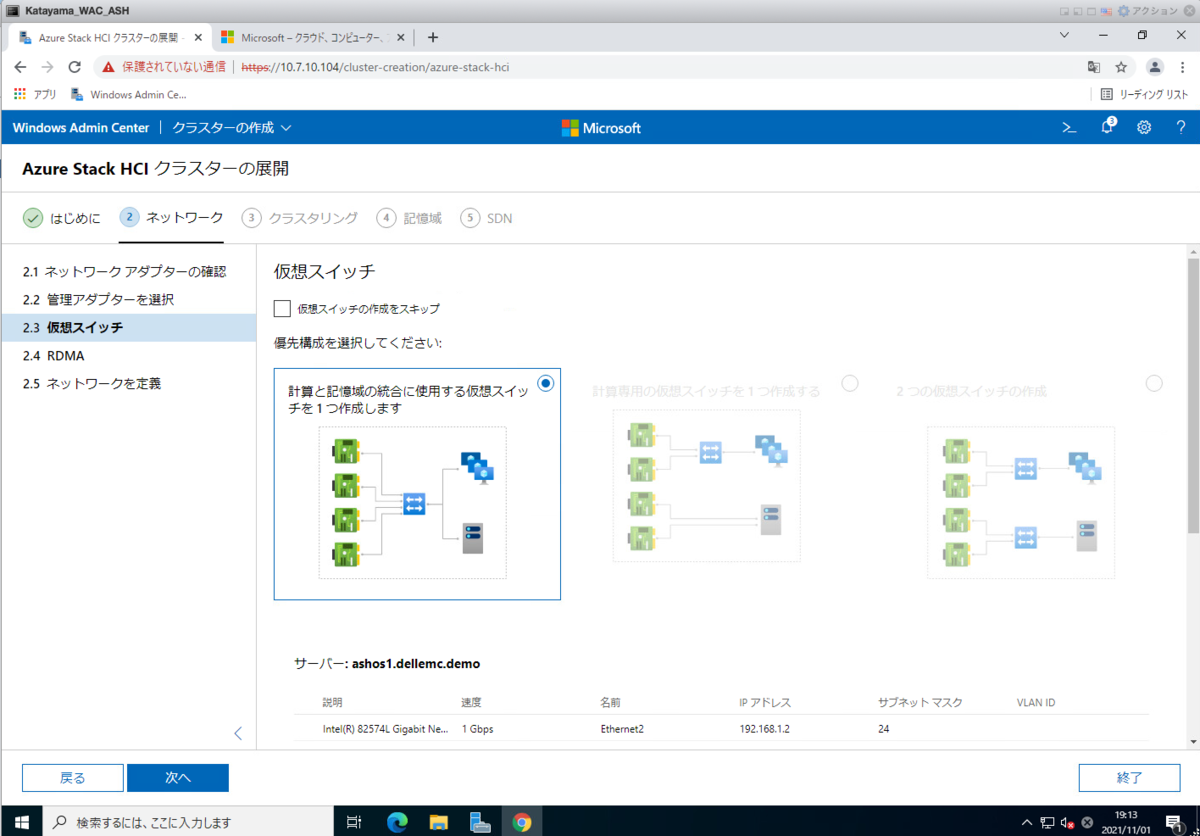

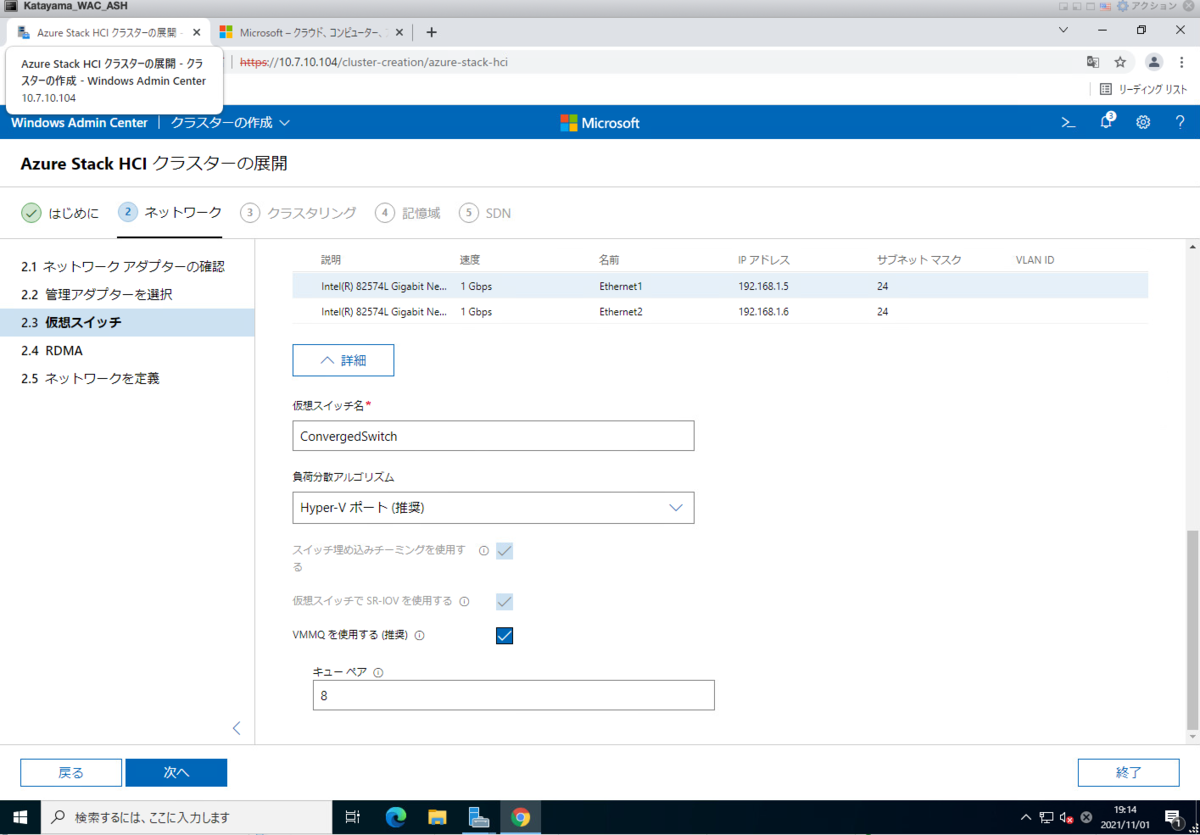

仮想スイッチを作成します。選択肢としては、3つあります。

仮想スイッチ名などもデフォルト名 "ConvergedSwitch" というのが入力されています。

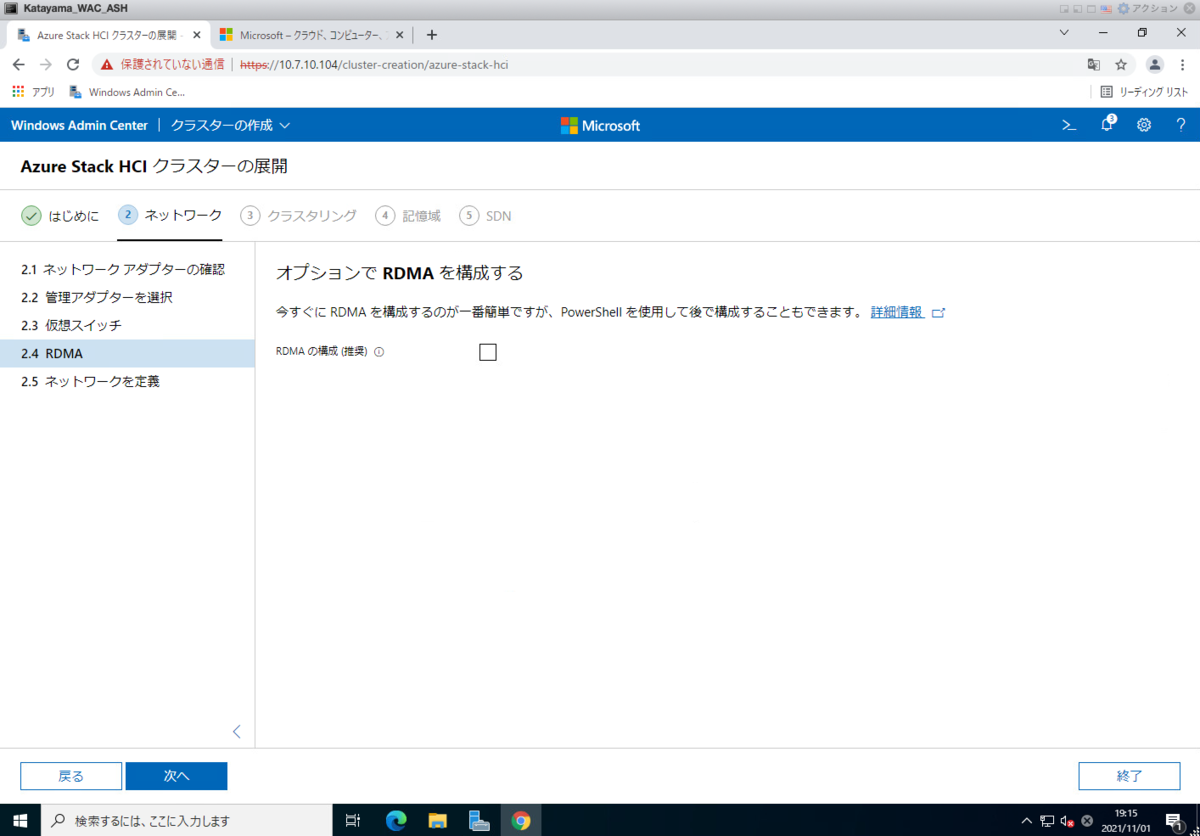

RDMA(Remote Direct Memory Access)の設定を有効化すことができる。

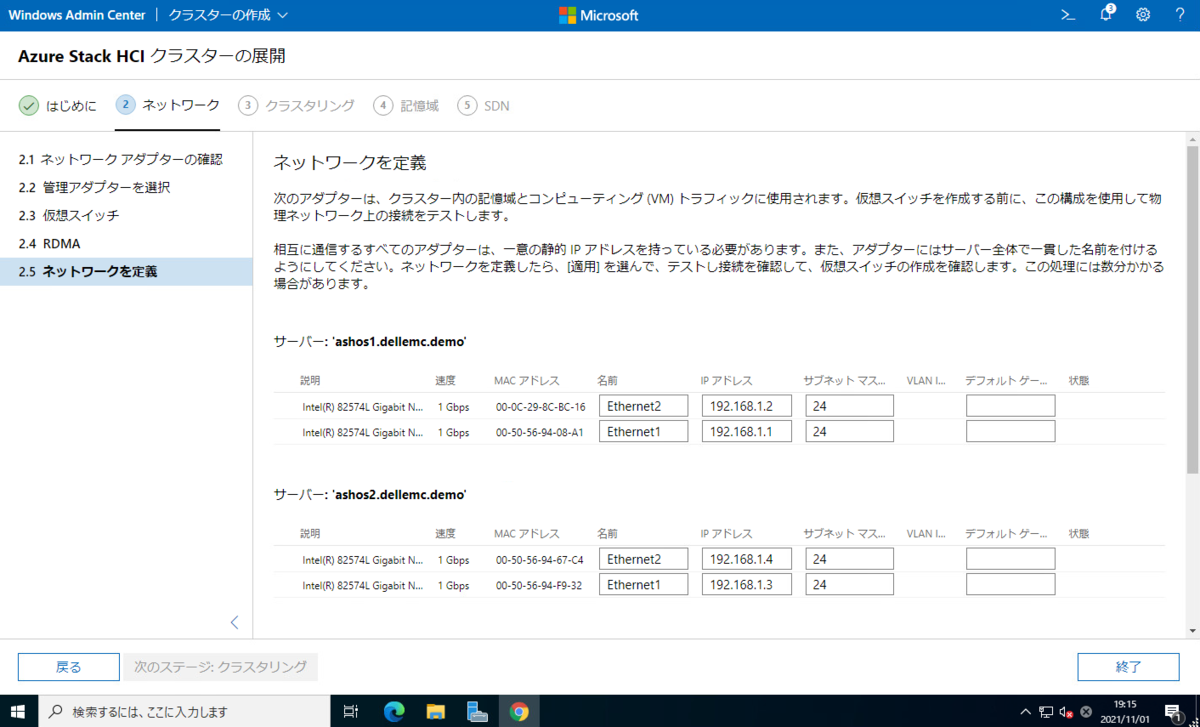

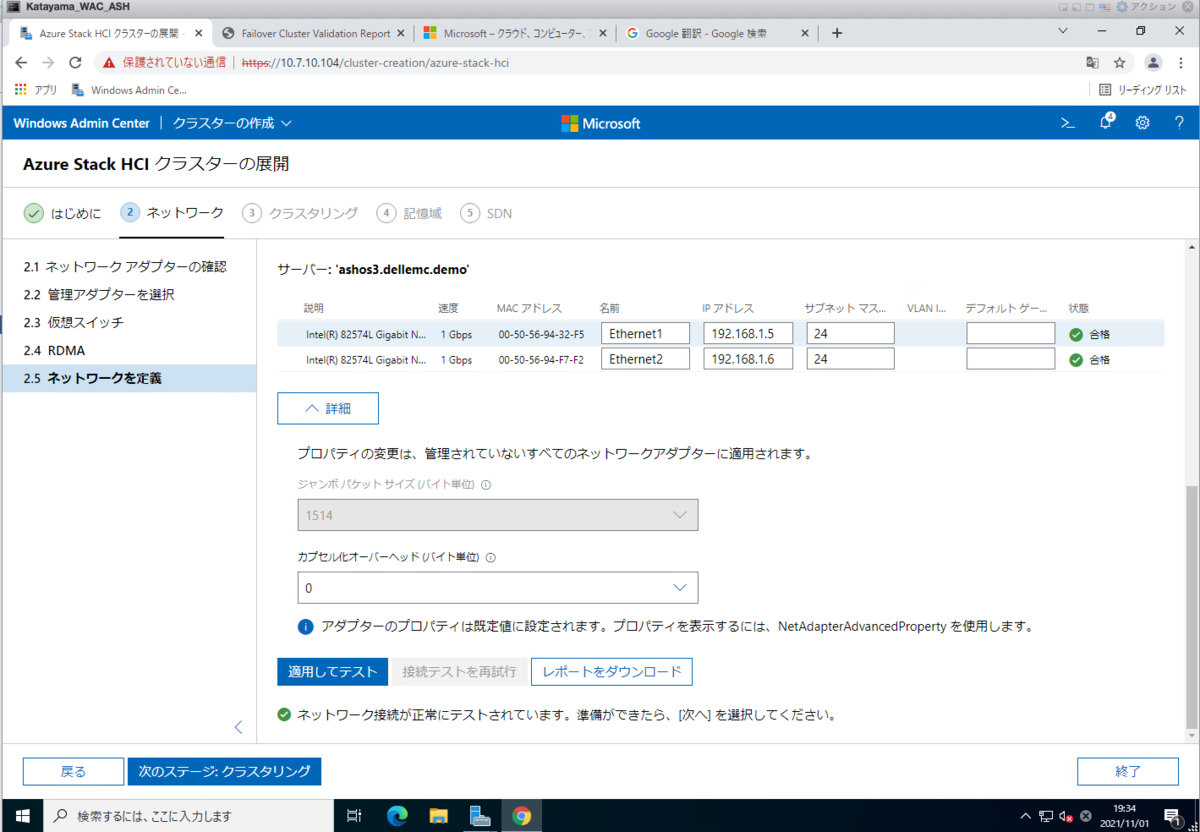

クラスター内のストレージ同期のネットワークにつかうIP Address の指定です。

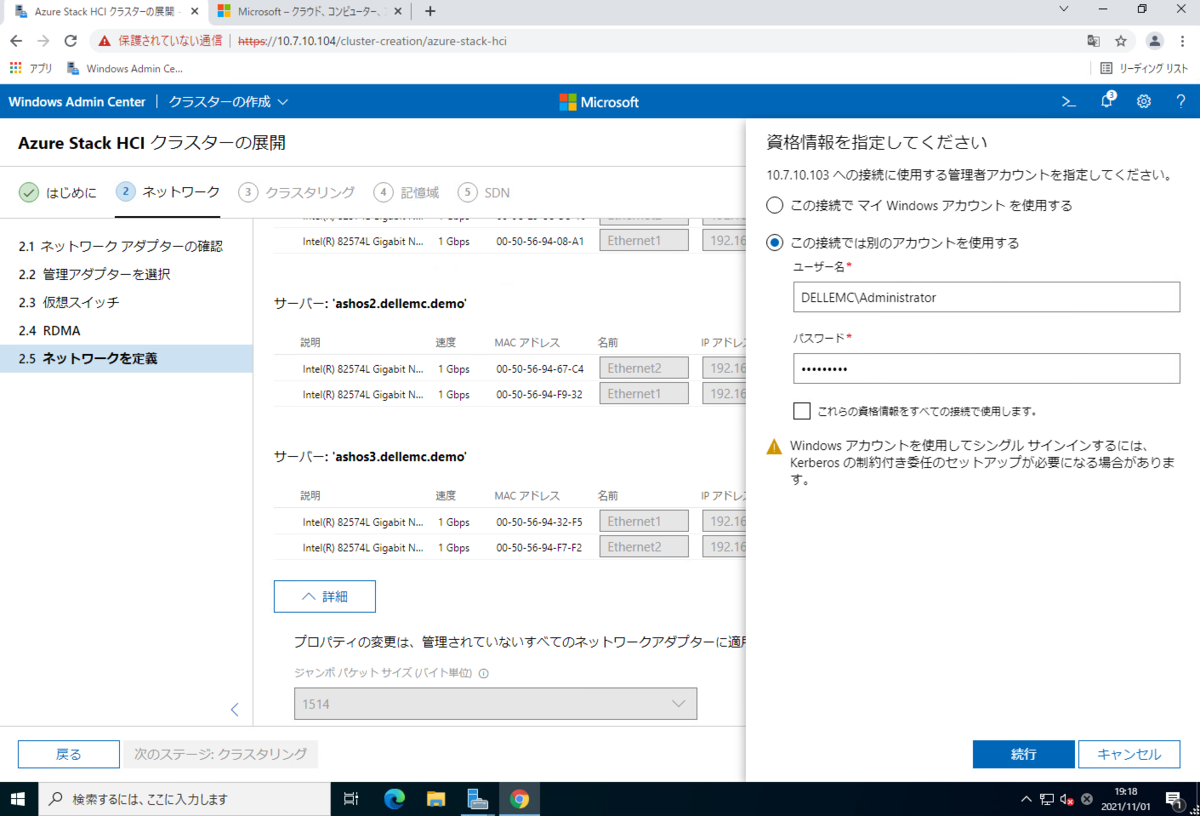

WACから ASH OS ノードに接続するときのアカウントを聞かれます。

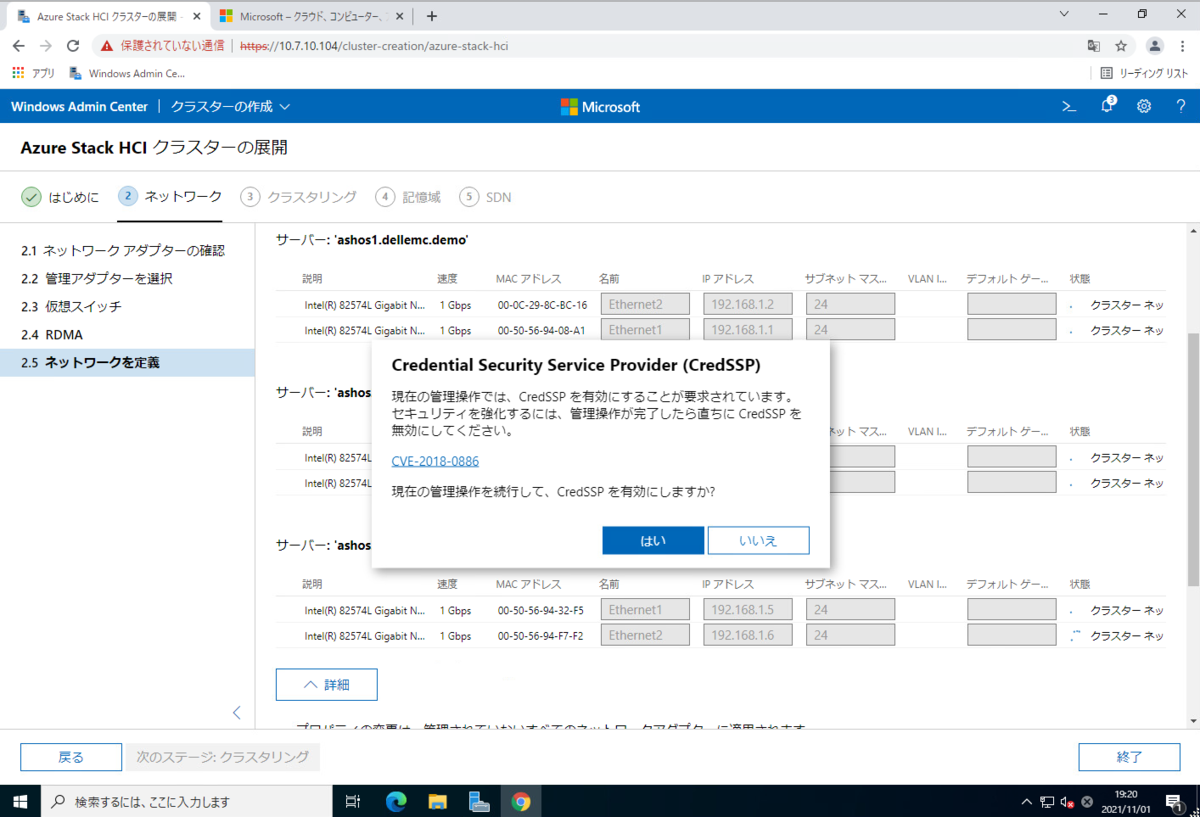

さらに、CredSSP を有効にするかどうかを聞かれます。

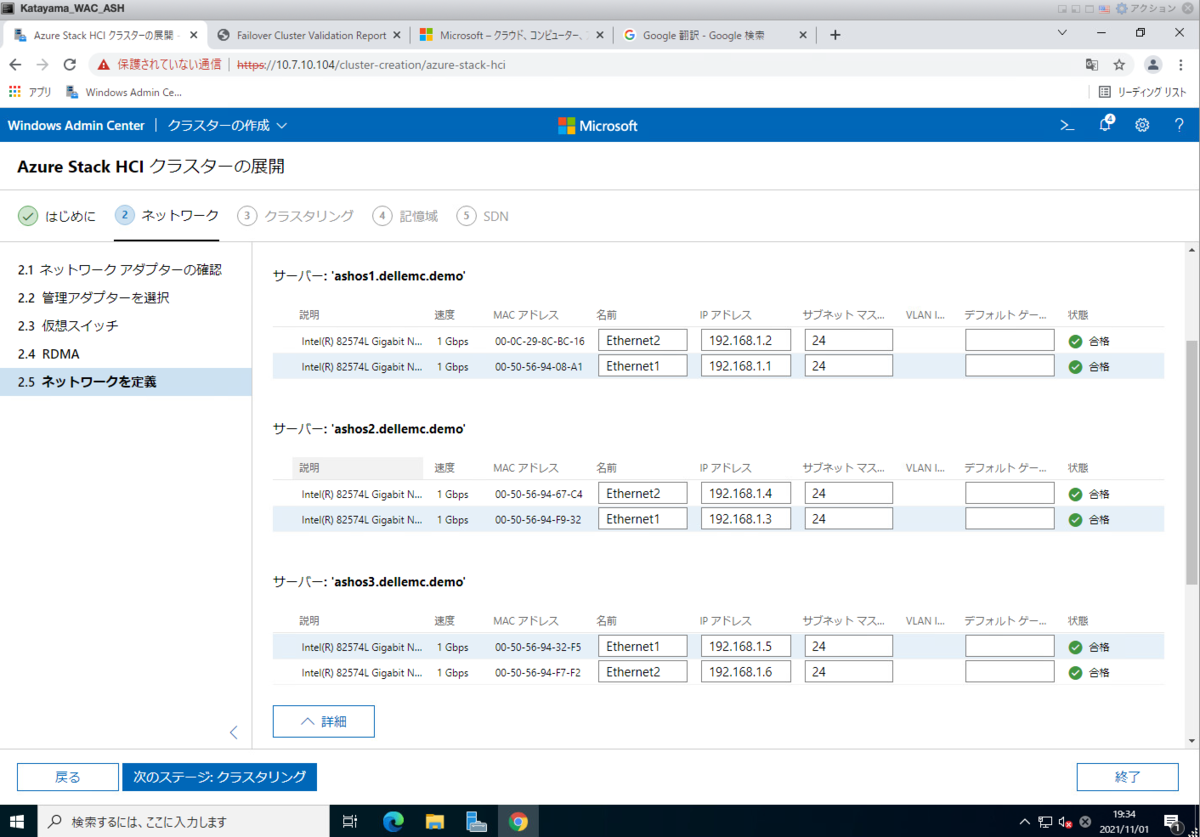

無事接続テストが完了します。

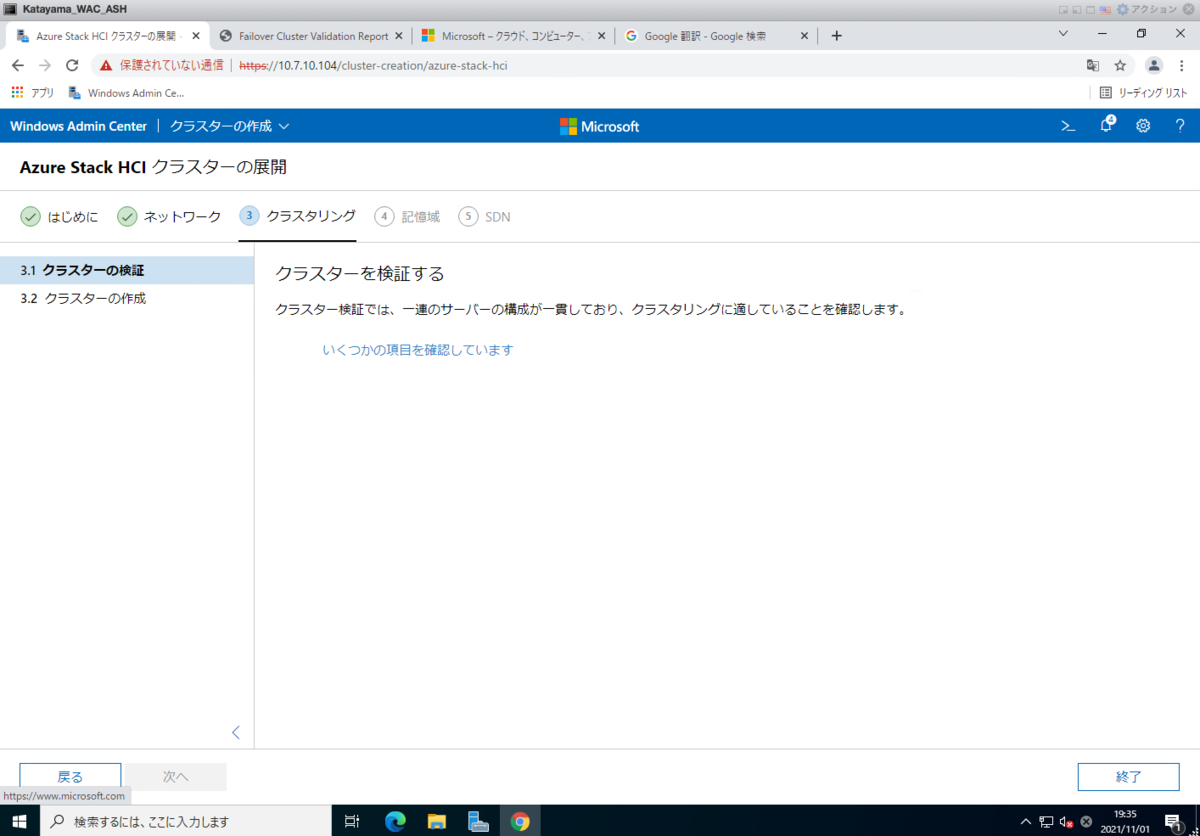

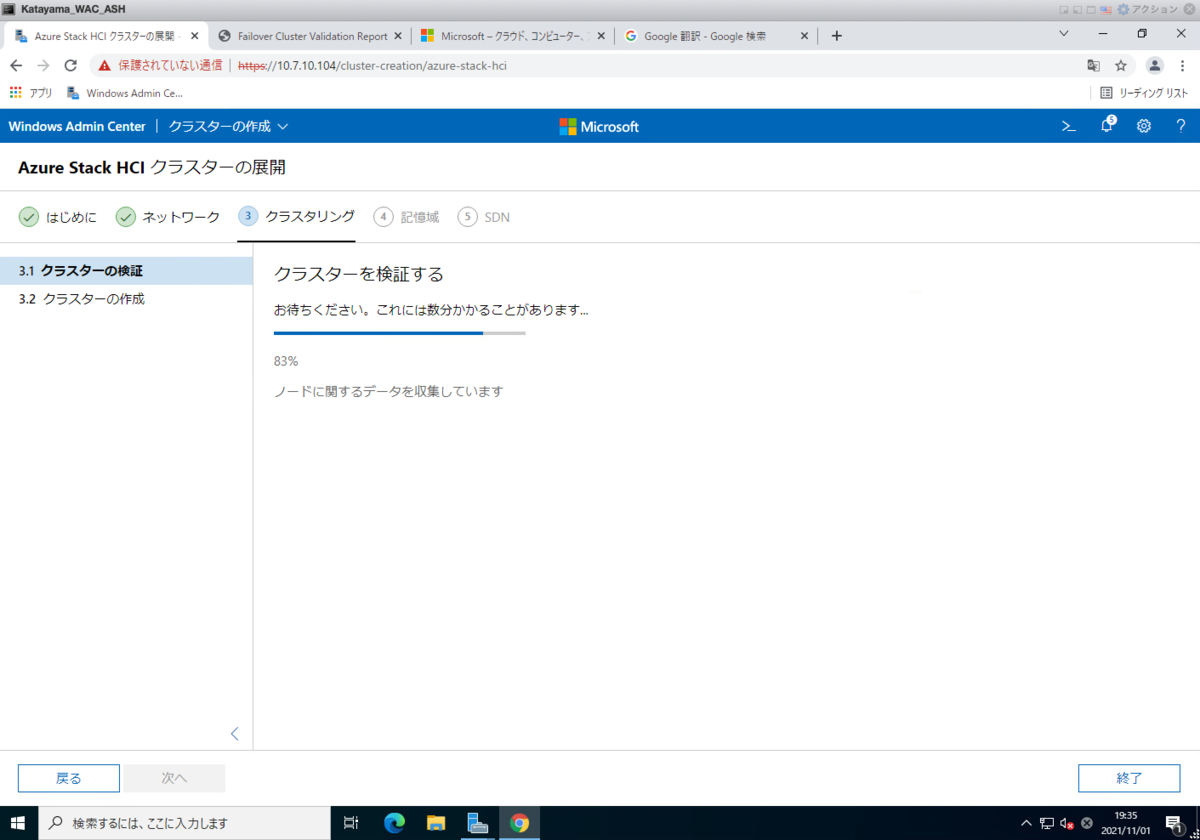

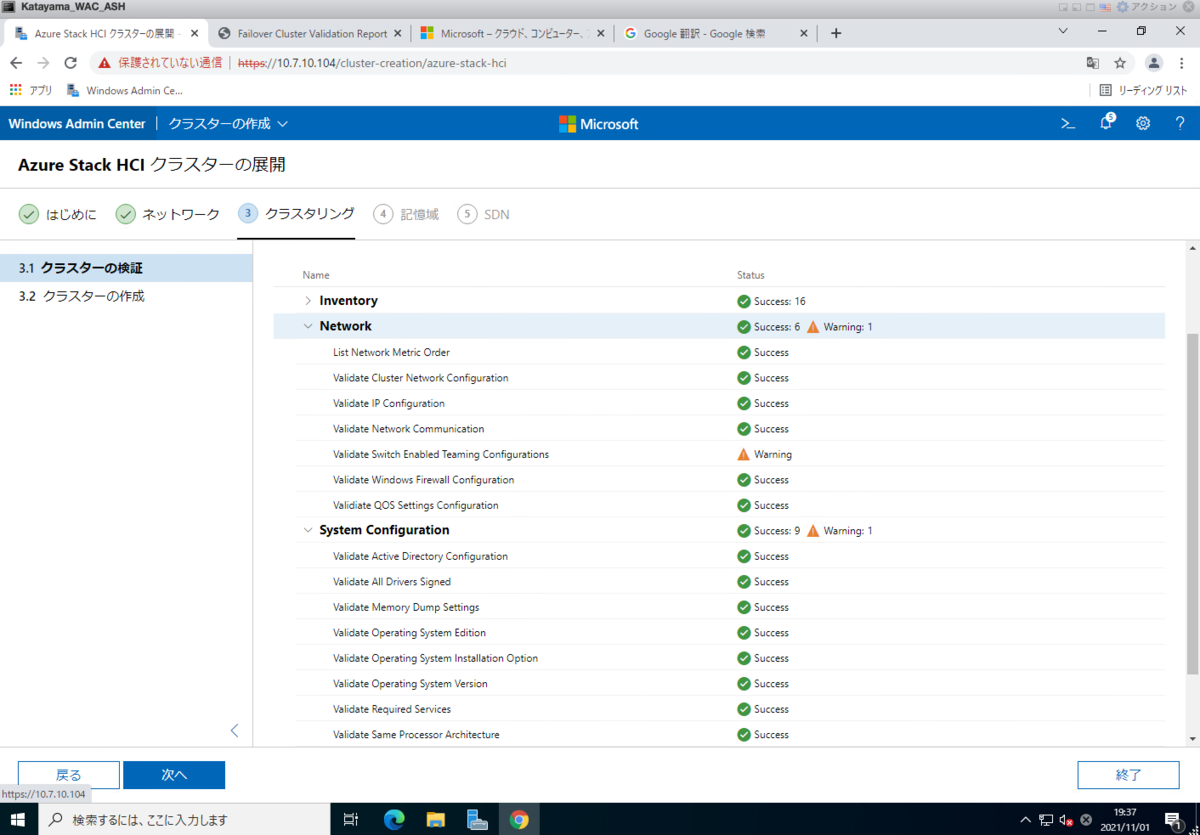

ボタンなどをクリックすることなく、自動的にクラスタが構成可能かチェックが実行されます。

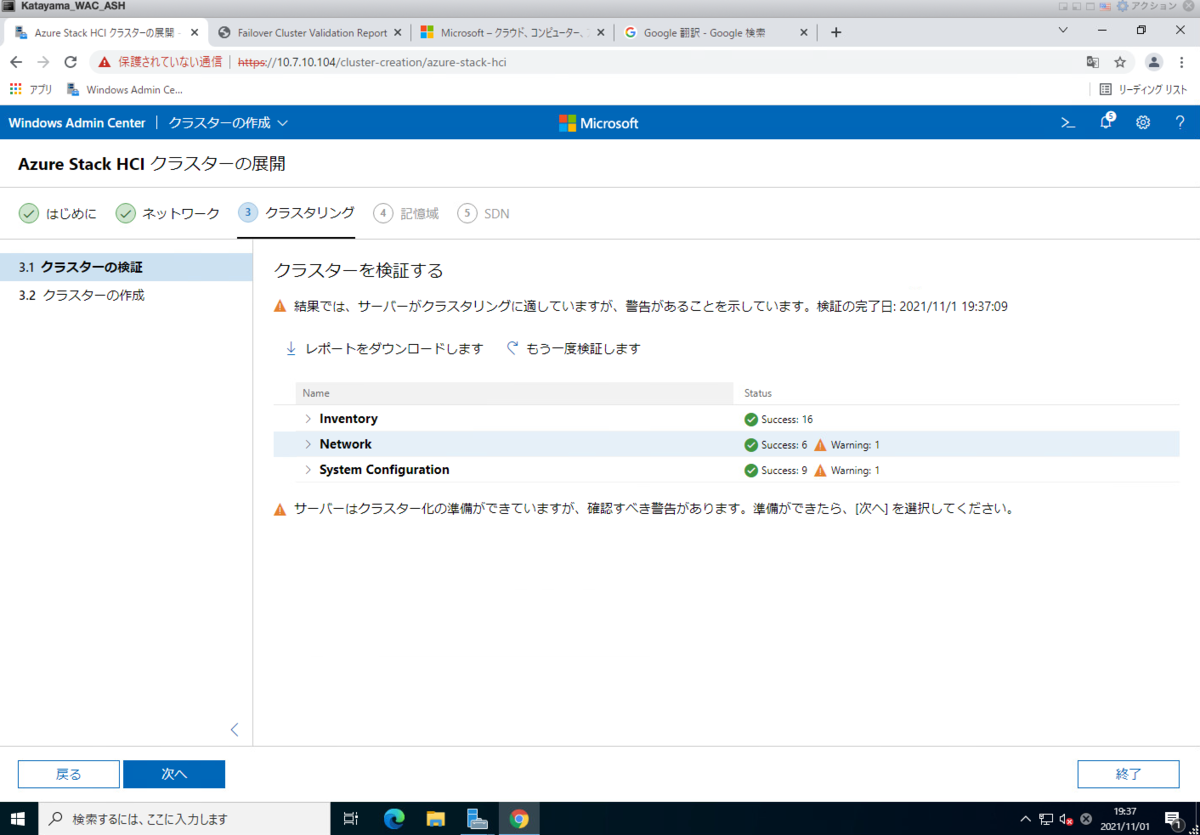

だいたい3分くらいで検証が行われました。

警告が出ていますね。

想定していた警告だったのでスルーします。

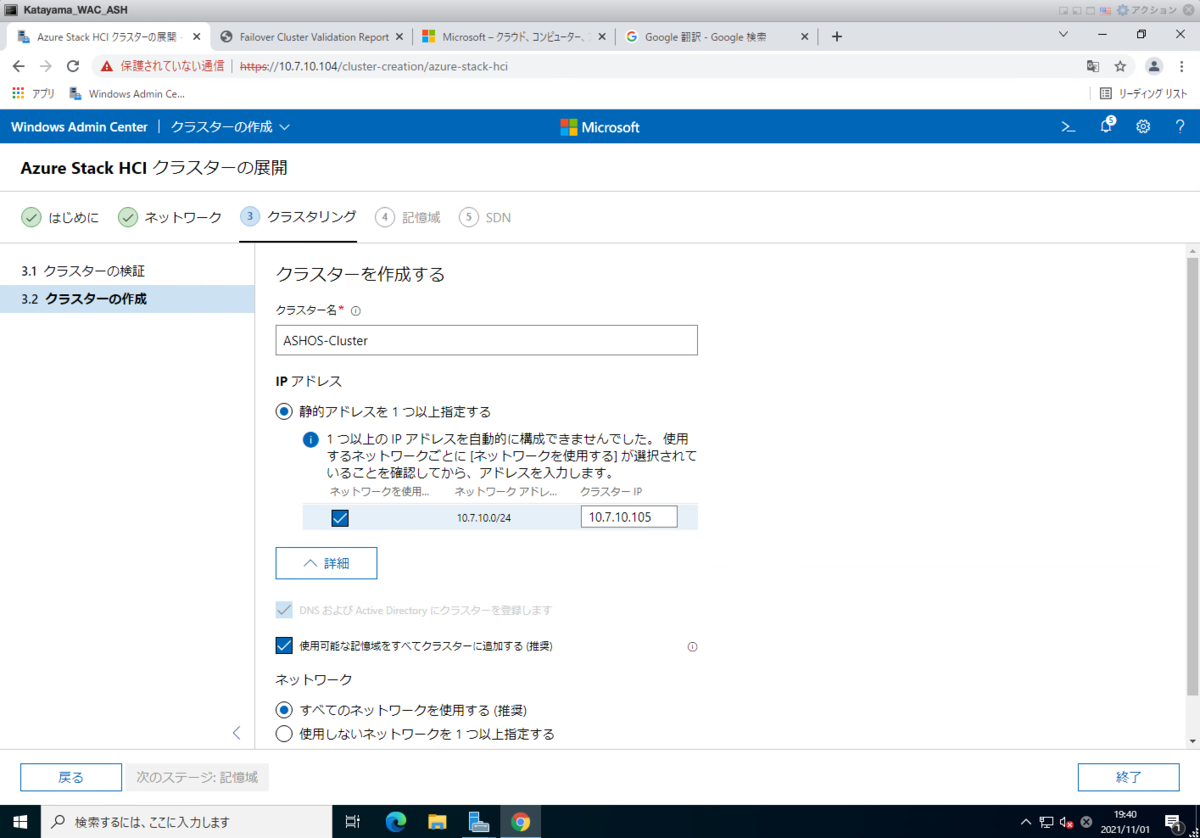

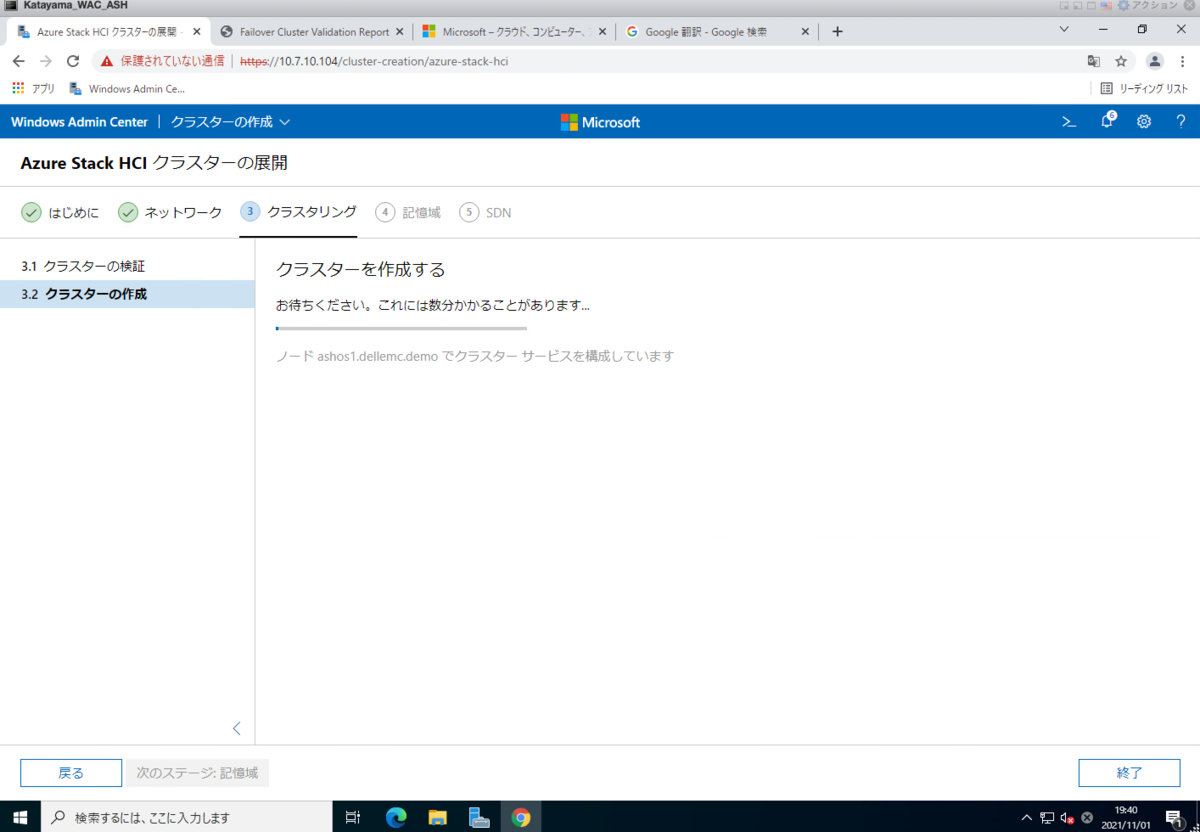

クラスター構成が開始されます。

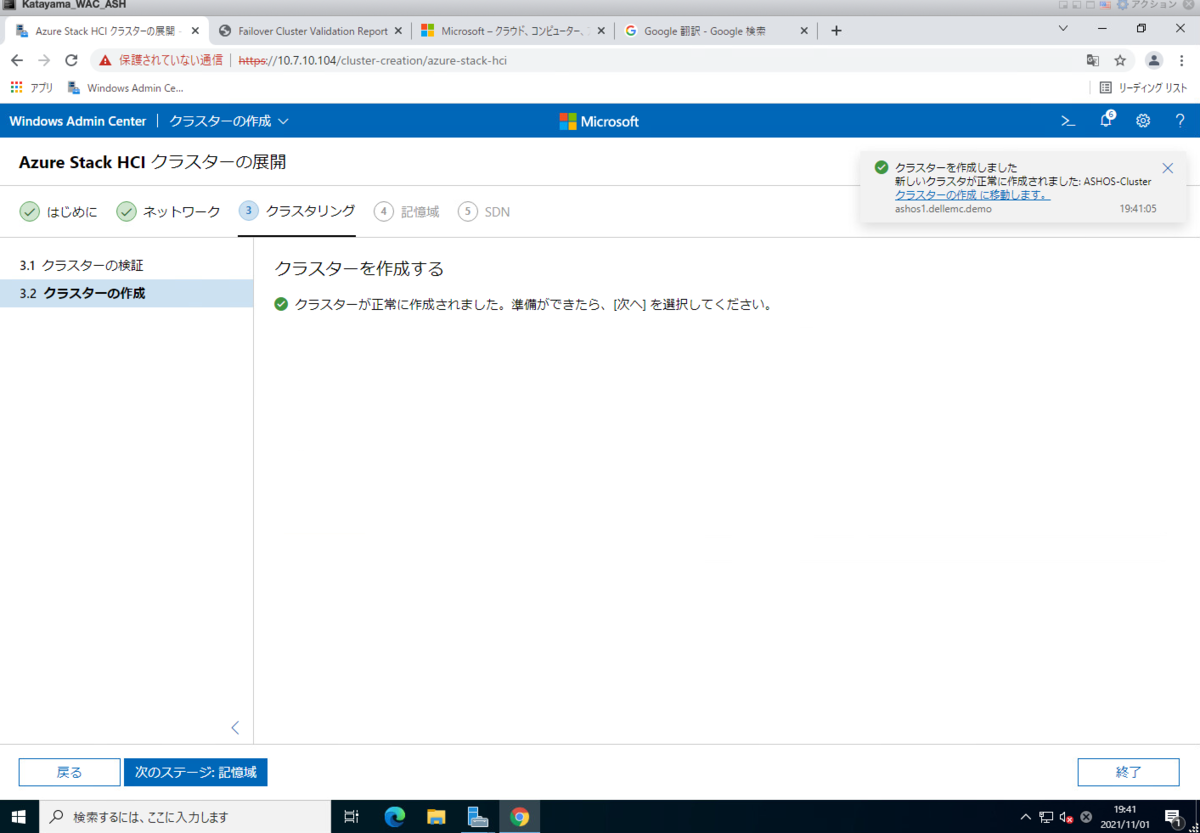

数分でクラスターが構成されました。(10分もかからなかったとおもいます)

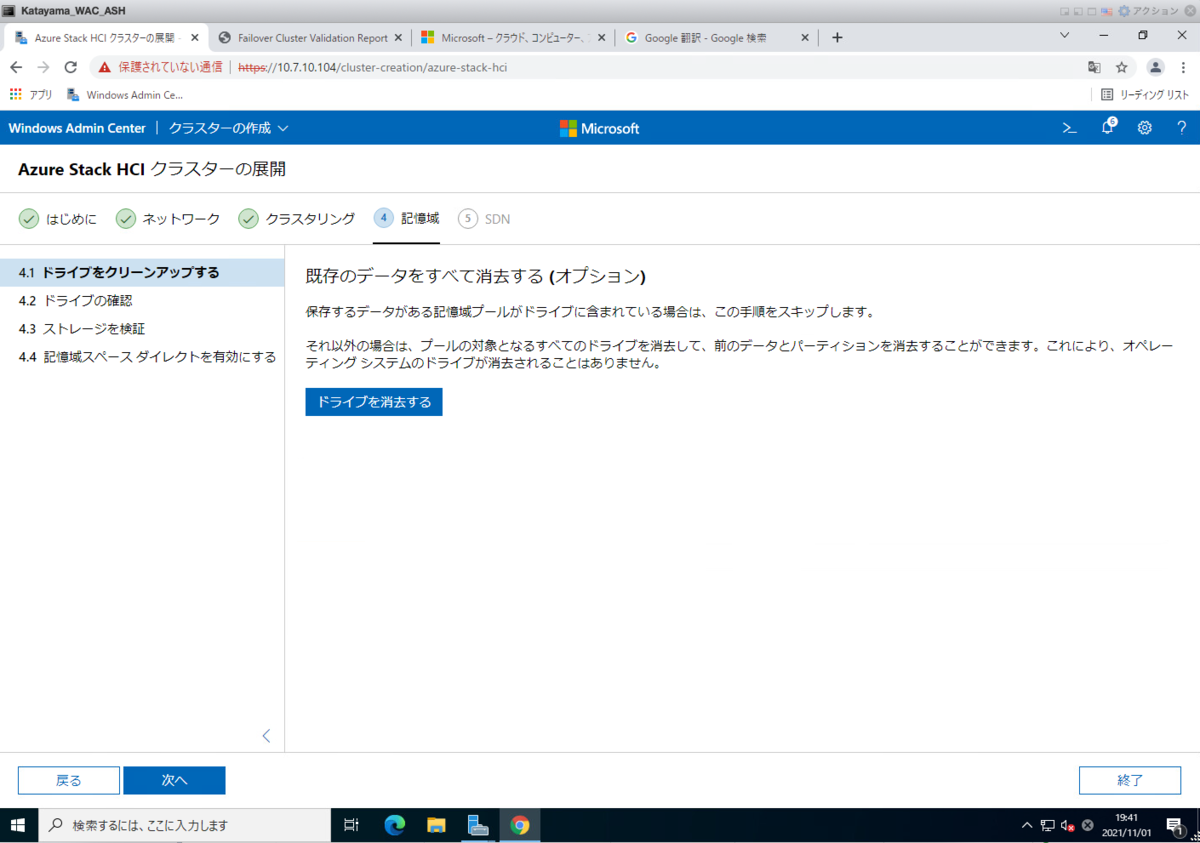

ついに 記憶域 の設定に入ってきましたね!

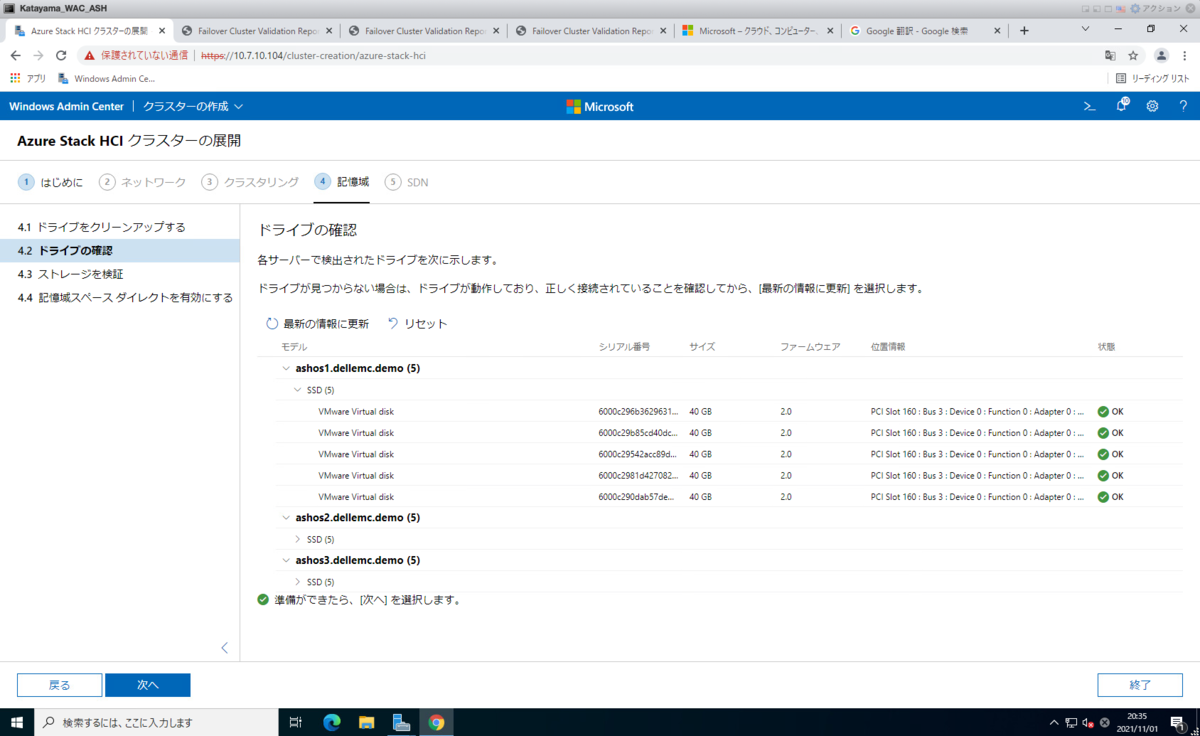

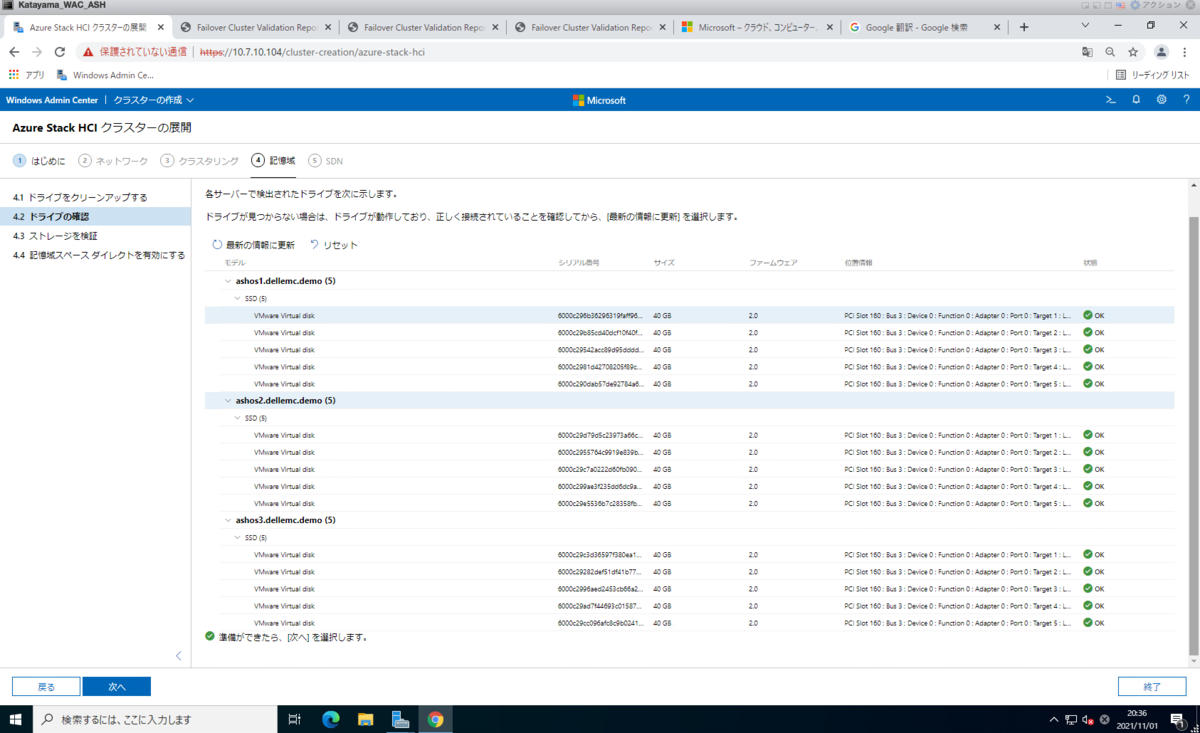

各ホストに SSD が5本接続されているのがわかります。

一応全部のSSD が見えている状態です。

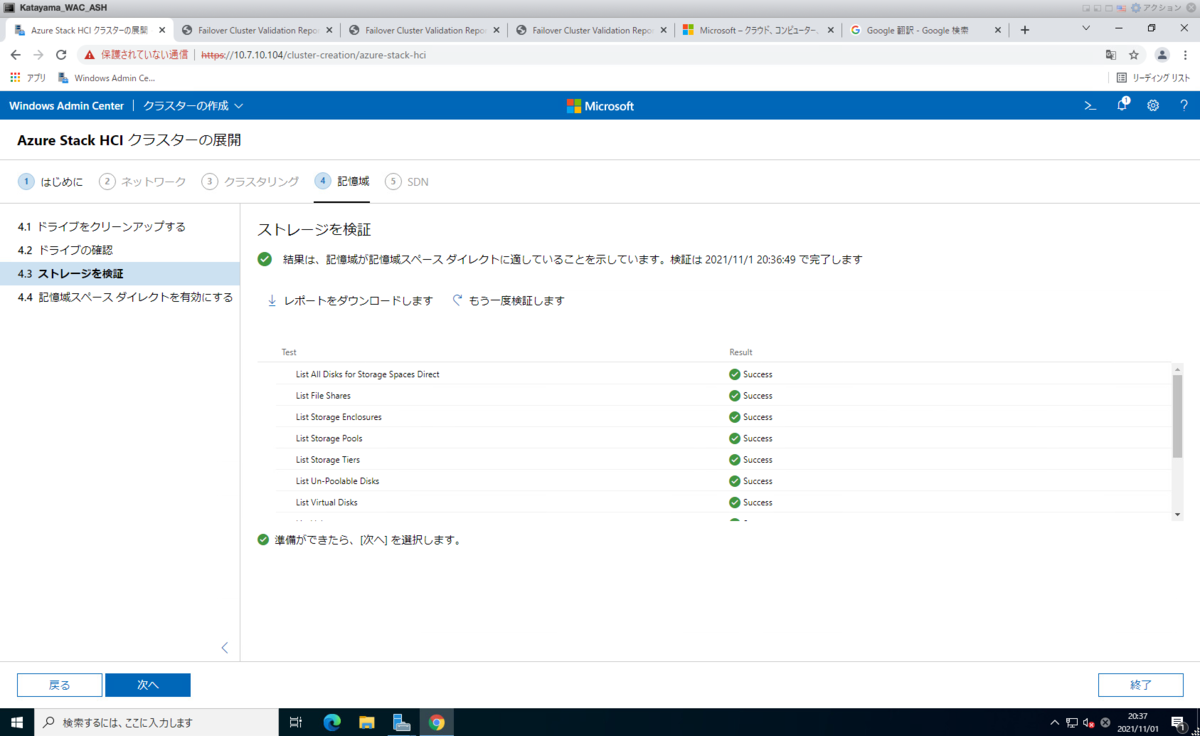

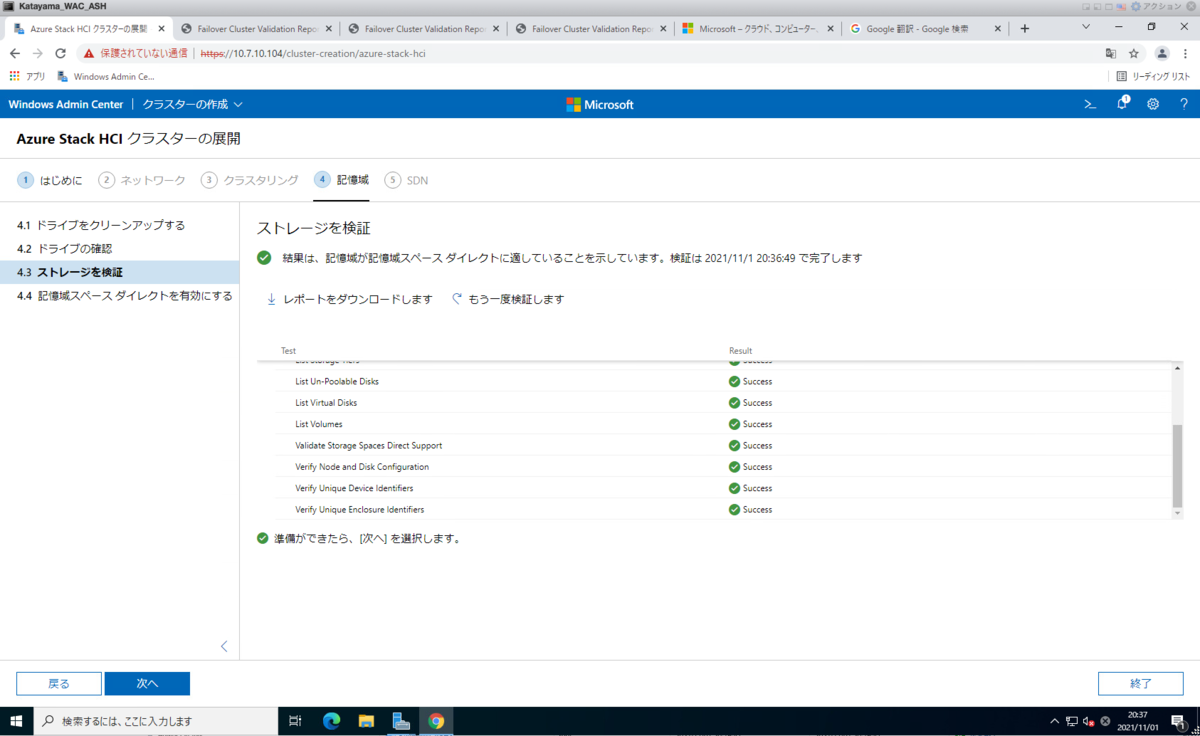

接続されているSSD がきちんと使えるかをチェックします。

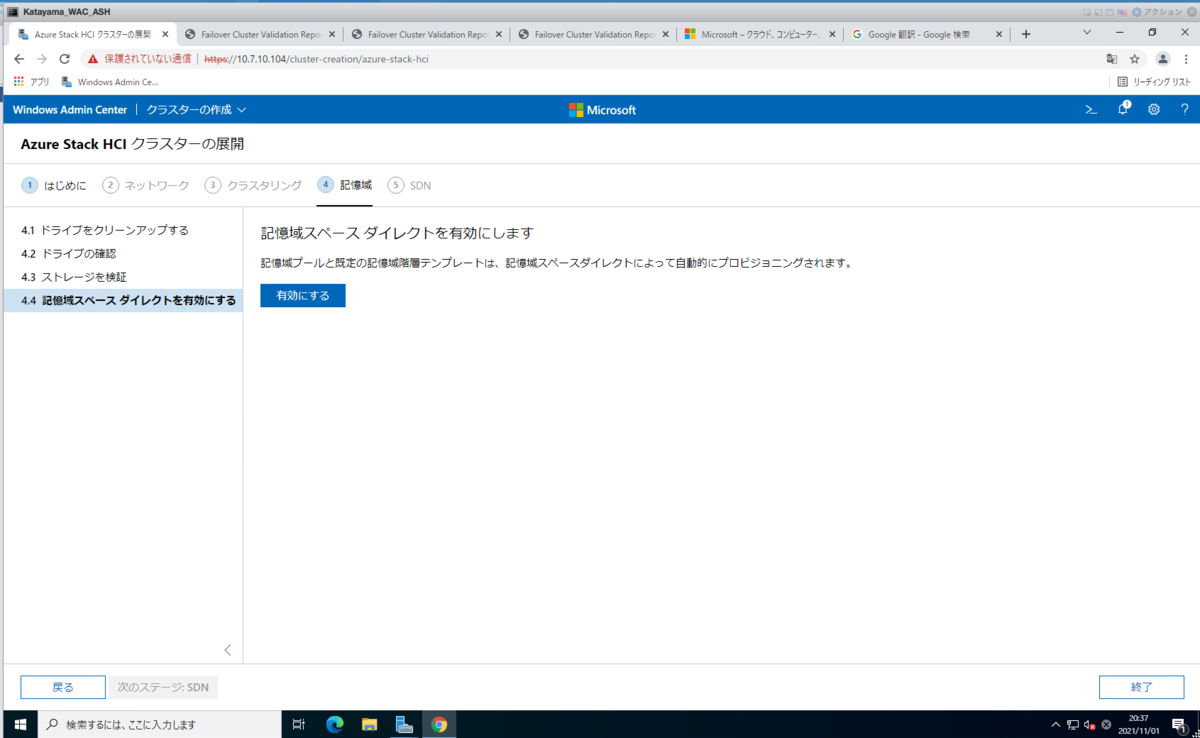

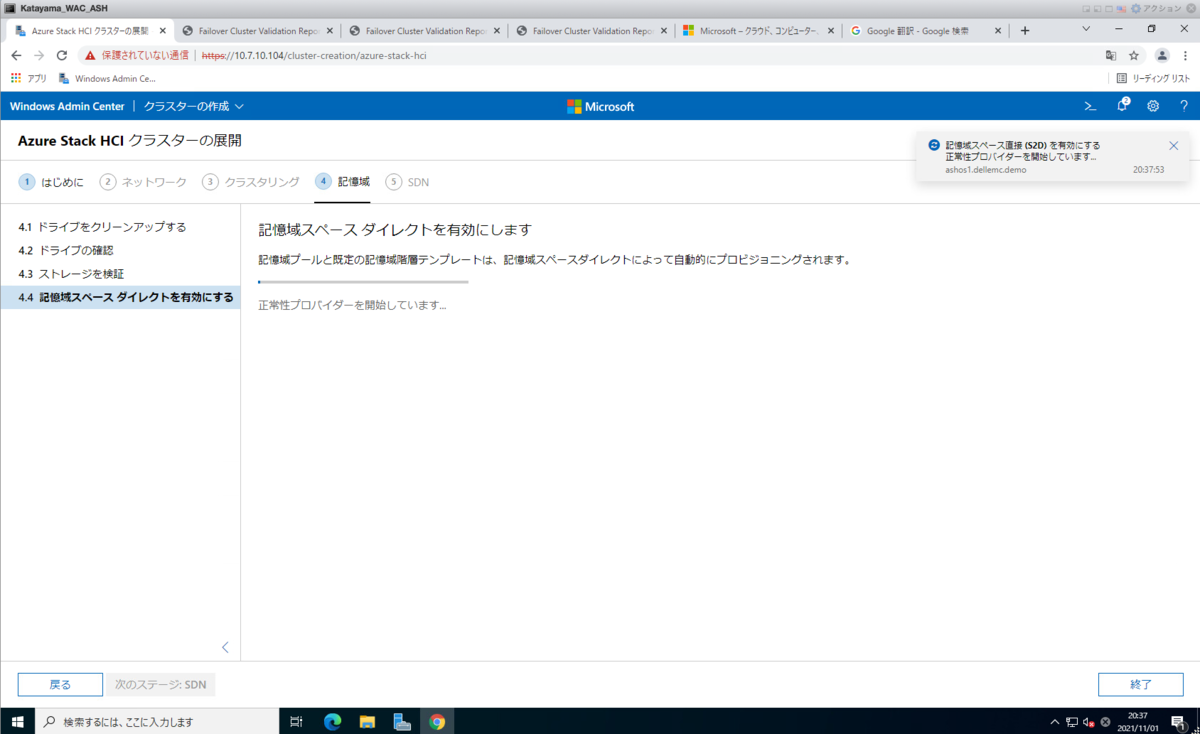

つ、ついに S2D(Storage Space Direct) の有効化です。

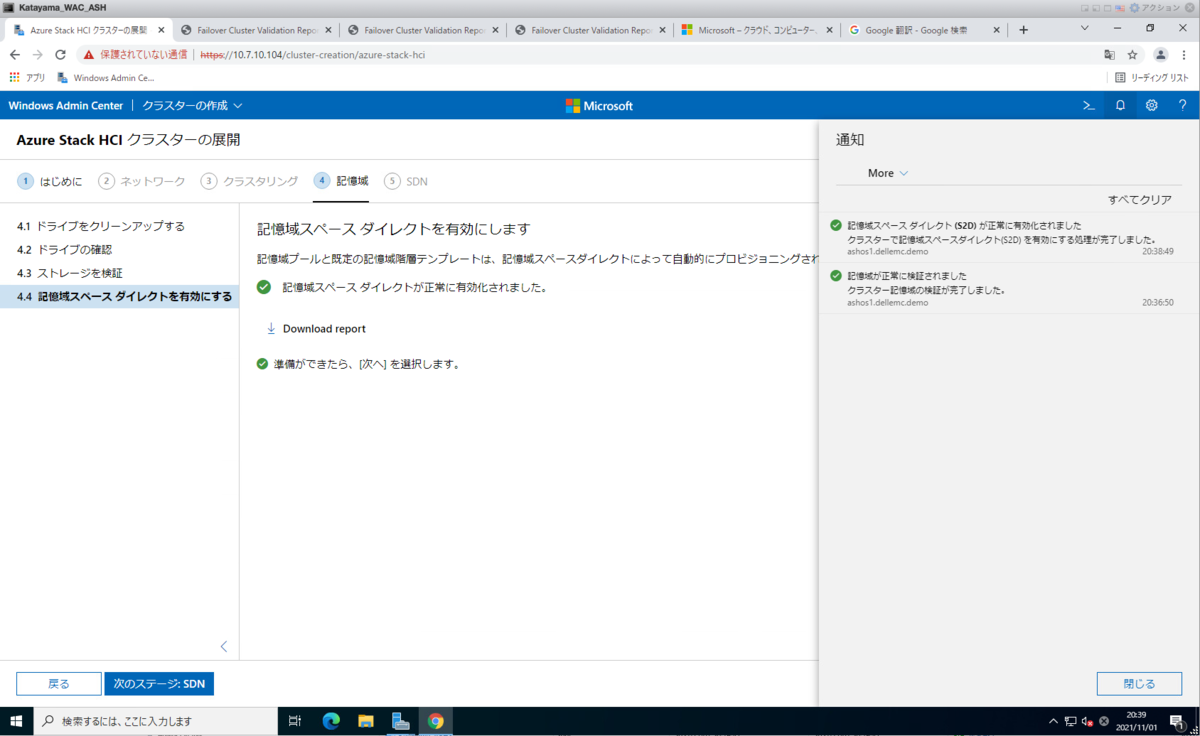

約2分くらいで Storage Space Direct は有効化されました!(はやい)

残りの作業

・SDN(Software Defined Network)の設定 →オプションなので今回はスキップ

・Azure Stack HCI OS を Microsoft Azure に登録 ※これしないと仮想マシン作成できない

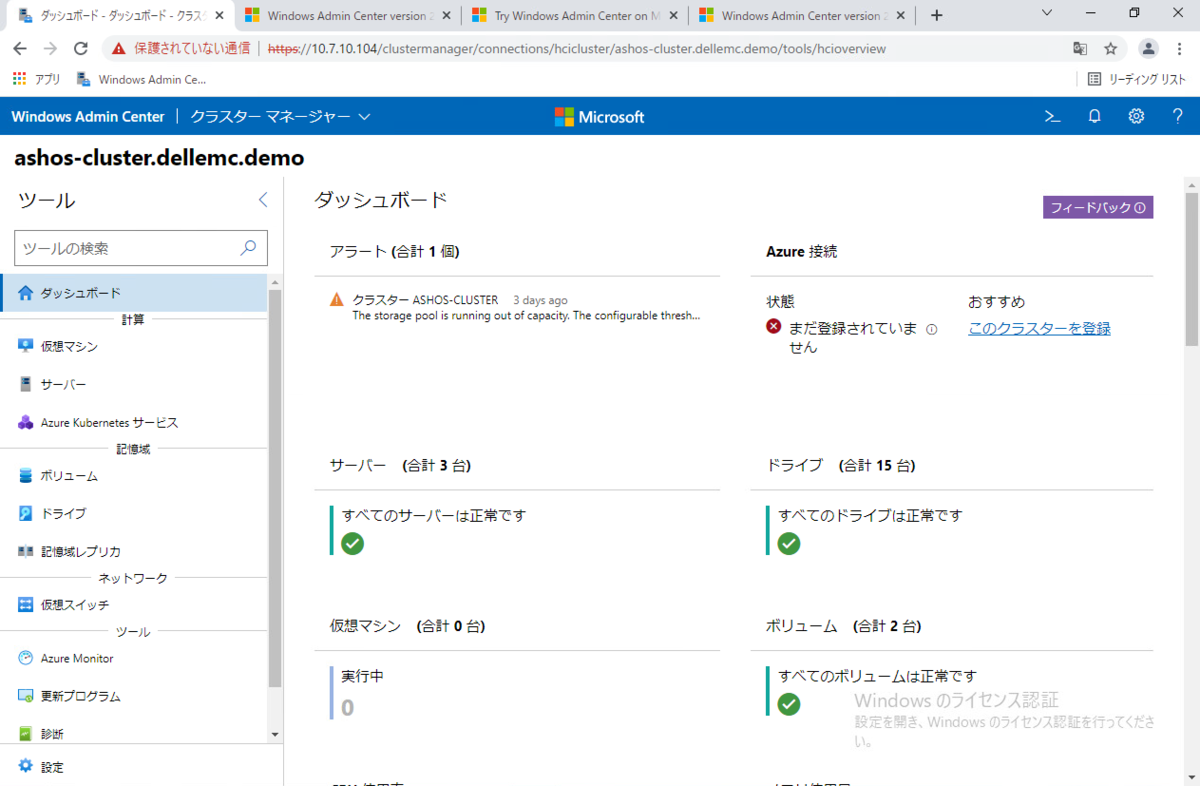

「Azure 接続」の部分から [このクラスターを登録] をクリックして進める必要があります。

今回は、構築の流れを知るために、私自信の備忘録にもなるかとおもって、流れを記載しました。

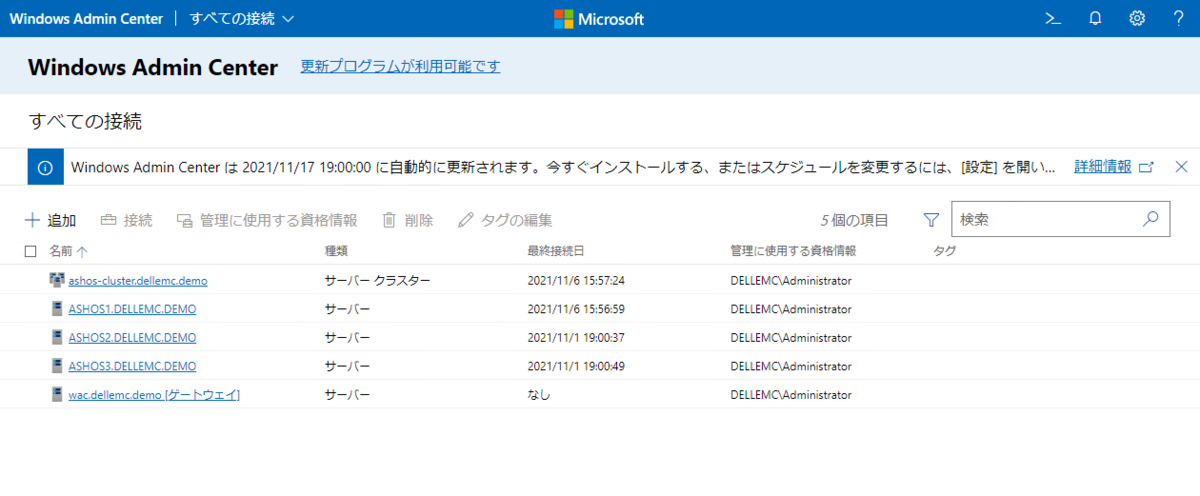

◆一覧

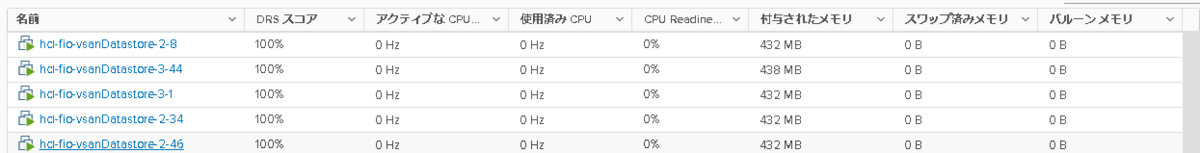

◆Azure Stack HCI OS 21H2 ノードの概要

総評

これまでコマンド(PowerShell)で構築するのがやっとだったAzure Stack HCI ですが、

Azure Arc とは なにか?

ワタクシが ハイブリッドクラウド研究会でお話しているYoutube があるので、是非みてくださいね😋

VIDEO www.youtube.com

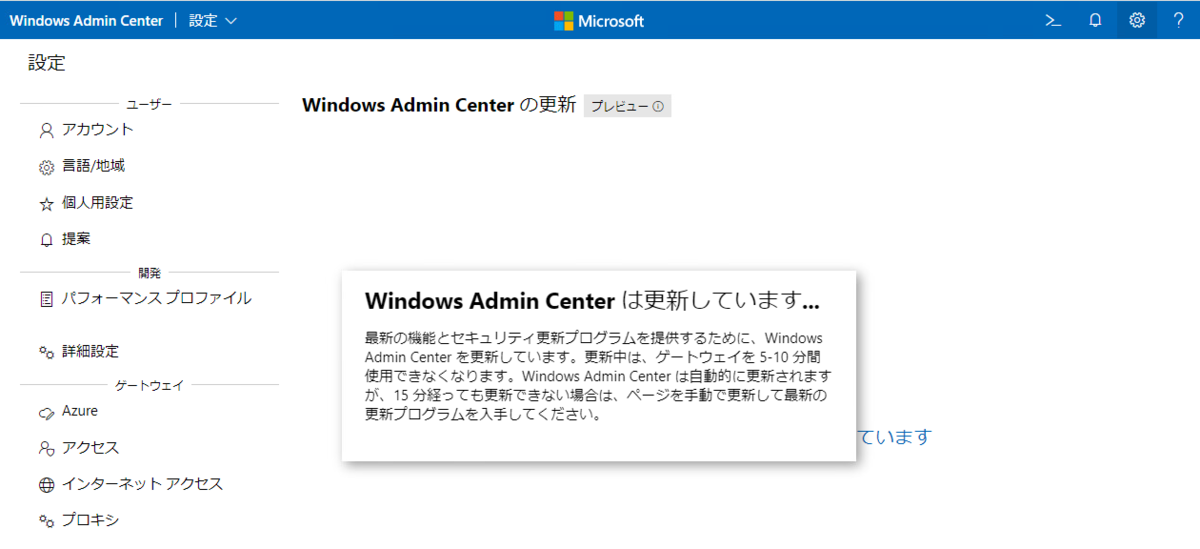

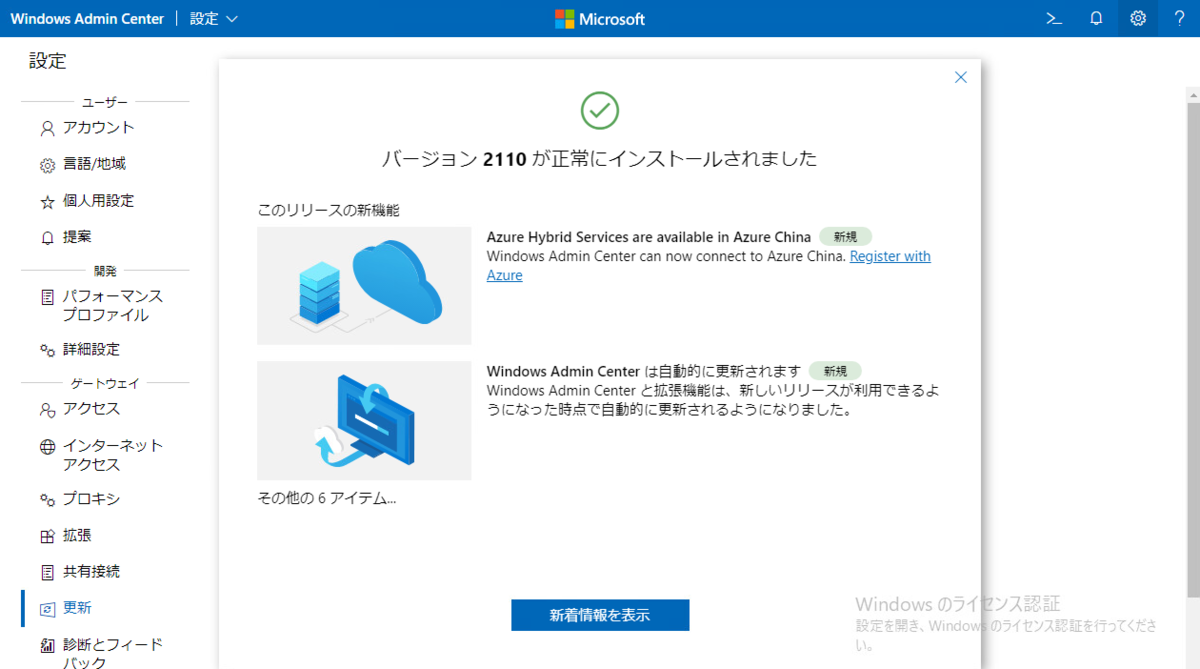

番外編) Windows Admin Center の更新を試してみるWindows Admin Center の新しいバージョンがたまたまリリースされたので、ついでに付録として記載します。

現在:1.3.2105.24004

次 :1.3.2111.01001

[更新プログラムのインストール] をクリックするとすぐに始まりました。

無事、3分くらいでインストールされました!

どんどん使い勝手がよくなってきている。

Azure Hybrid たのしくなってきましたね。

かたやん