今回は取得したサポートバンドル(vm-support)の中を見ていく第3弾。

地道に3回目を迎えた vm-support の記事。

ESXi上で稼働する仮想マシンたちは、当然ながら個々の仮想マシン内でログを吐きます。

Windows Server であれば、システムログ、アプリケーションログ などが一般的ですし、Linuxであればmessagesなどがありますね。

それらに加え、ESXiは個別にそれぞれの仮想マシンのログ(vmware.log)というログを保持しています。

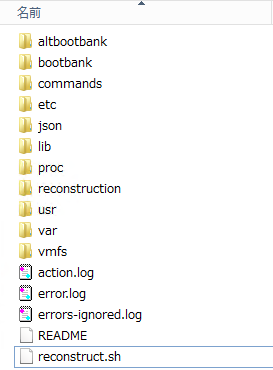

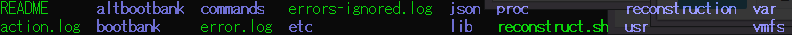

場所はデフォルトではここです。

vm-supportを取得して解凍したファイルのディレクトリ構造も同じです。

> /vmfs/volumes/<データストア名>/<仮想マシン名>/

ログは仮想マシンが再起動 or 起動するたびにローテーションされ、数字で連番がついていきます。

vmware.log

vmware-1.log

vmware-2.log

vmware-3.log

vmware-4.log

ここで注意したいのは、このvmware.log は、仮想マシンの再起動のタイミングでローテーションするので、

長期間稼働し続けている仮想マシンが存在する場合、特大サイズになっていることがあります。

いざ、VMware社へ vm-support を提供しようした際、

ログバンドル(vm-support)が特大サイズで生成され、解凍した際のログのサイズが

100GBを超えたことがある環境もあるらしいです。(恐ろしい)

話はもどりますが、仮想マシンに問題が発生した場合、

主に見るべきログは、ゲストOS自体のログとESXiに保持されているvmware.log です。

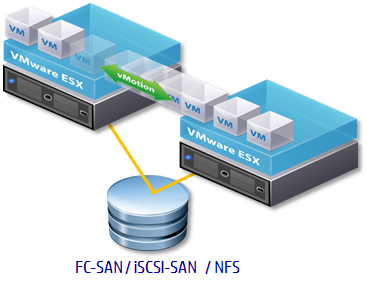

もしvMotion や Cold Migration 時に挙動がおかしくなった場合はhostd.logを見る場合もありますが、まずは上記のログを見ます。

vmware.logですが、多くの情報を残してくれます。

例として、ゲストOSとして動作しているWindows Server 2008 R2 にNMIを発行し、

BSOD(Blue Screen of Death)を発生させ、vmware.log に何が記録されるか見てみましょう。

1. Windows Server 2008 R2 のゲストにNMIを発行します。

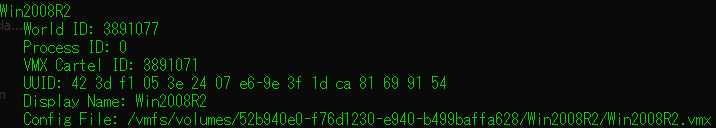

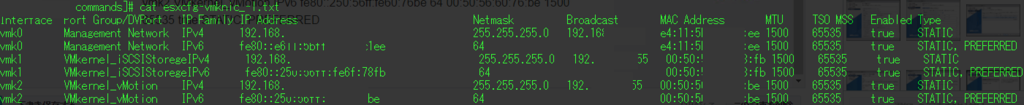

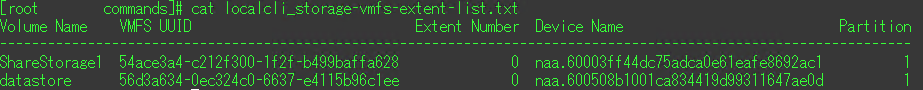

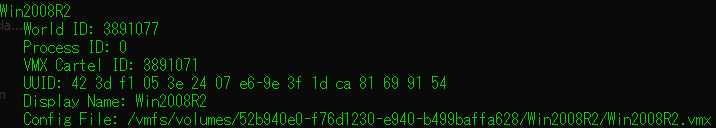

esxcli vm process listコマンドを実行し、パワーオン中の仮想マシンの情報を表示させます。

クラッシュダンプ作成対象の仮想マシンのWorld IDをメモします。

ここでは「World ID : 3891077 」と表示されています。

2.ゲストOSである Windows Server 2008 R2 側以下のレジストリ設定をしておく。

HKEY_LOCAL_MACHINE\SYSTEM\CurrentControlSet\Control\CrashControl

[新規] から [DWORD 値] をクリックし、追加された DWORD 値の名前に ”NMICrashDump” と入力し、ENTER キーを押したあと、

[値のデータ] の空欄に ”1” を入力し [OK] ボタンをクリックします。

この部分はここを見てほしい。

メモリ ダンプ ファイルを生成する方法について | Ask CORE

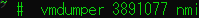

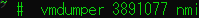

3.ではESXiから vmdumper コマンドでNMIを発行します。

先ほどWorld ID を調べたので、World ID を指定したコマンドを実行します。

> vmdumper 3891077 nmi

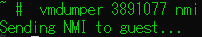

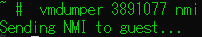

実行後↓

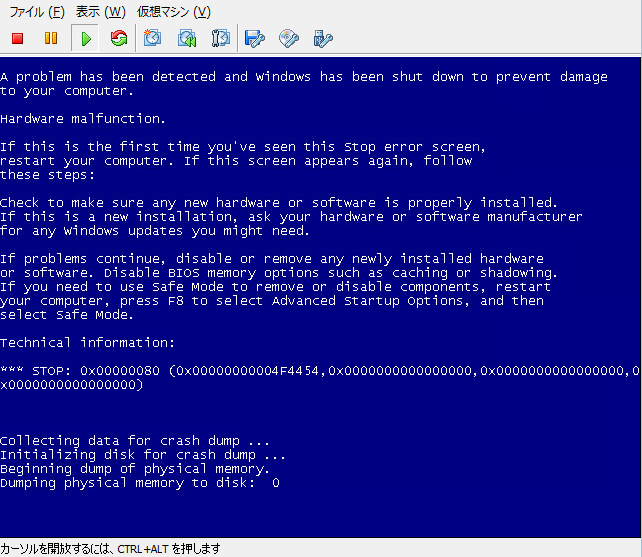

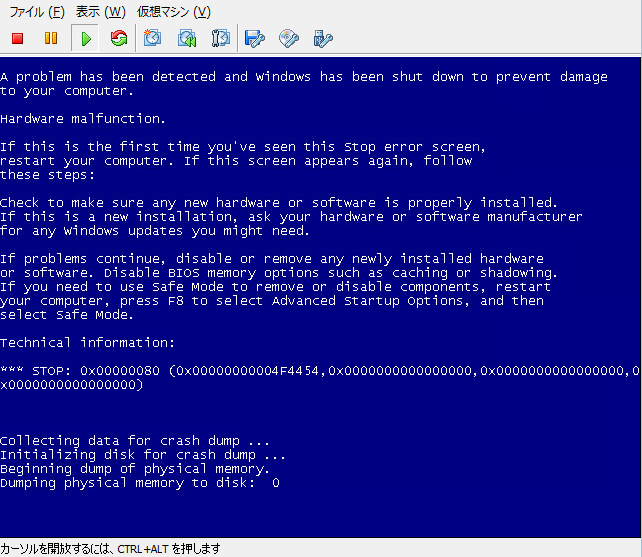

4. コマンド実行直後に仮想マシンはBSODになります。

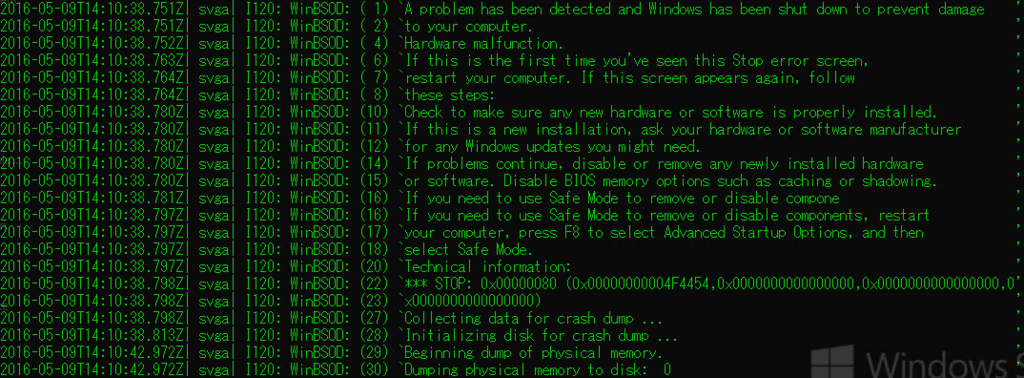

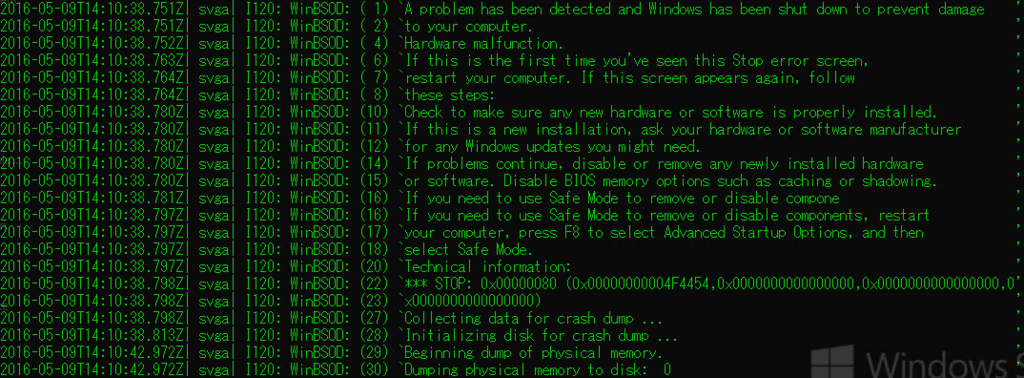

5. BSODになったので、vmware.log を見てみます。

きちんとBSODが発生したことや、STOPコードまで記録されています。

◆vmware.log(テキスト)

2016-05-09T14:10:38.751Z| svga| I120: WinBSOD: ( 1) `A problem has been detected and Windows has been shut down to prevent damage '

2016-05-09T14:10:38.751Z| svga| I120: WinBSOD: ( 2) `to your computer. '

2016-05-09T14:10:38.752Z| svga| I120: WinBSOD: ( 4) `Hardware malfunction. '

2016-05-09T14:10:38.763Z| svga| I120: WinBSOD: ( 6) `If this is the first time you've seen this Stop error screen, '

2016-05-09T14:10:38.764Z| svga| I120: WinBSOD: ( 7) `restart your computer. If this screen appears again, follow '

2016-05-09T14:10:38.764Z| svga| I120: WinBSOD: ( 8) `these steps: '

2016-05-09T14:10:38.780Z| svga| I120: WinBSOD: (10) `Check to make sure any new hardware or software is properly installed. '

2016-05-09T14:10:38.780Z| svga| I120: WinBSOD: (11) `If this is a new installation, ask your hardware or software manufacturer '

2016-05-09T14:10:38.780Z| svga| I120: WinBSOD: (12) `for any Windows updates you might need. '

2016-05-09T14:10:38.780Z| svga| I120: WinBSOD: (14) `If problems continue, disable or remove any newly installed hardware '

2016-05-09T14:10:38.780Z| svga| I120: WinBSOD: (15) `or software. Disable BIOS memory options such as caching or shadowing. '

2016-05-09T14:10:38.781Z| svga| I120: WinBSOD: (16) `If you need to use Safe Mode to remove or disable compone '

2016-05-09T14:10:38.797Z| svga| I120: WinBSOD: (16) `If you need to use Safe Mode to remove or disable components, restart '

2016-05-09T14:10:38.797Z| svga| I120: WinBSOD: (17) `your computer, press F8 to select Advanced Startup Options, and then '

2016-05-09T14:10:38.797Z| svga| I120: WinBSOD: (18) `select Safe Mode. '

2016-05-09T14:10:38.797Z| svga| I120: WinBSOD: (20) `Technical information: '

2016-05-09T14:10:38.798Z| svga| I120: WinBSOD: (22) `*** STOP: 0x00000080 (0x00000000004F4454,0x0000000000000000,0x0000000000000000,0'

2016-05-09T14:10:38.798Z| svga| I120: WinBSOD: (23) `x0000000000000000) '

2016-05-09T14:10:38.798Z| svga| I120: WinBSOD: (27) `Collecting data for crash dump ... '

2016-05-09T14:10:38.813Z| svga| I120: WinBSOD: (28) `Initializing disk for crash dump ... '

2016-05-09T14:10:42.972Z| svga| I120: WinBSOD: (29) `Beginning dump of physical memory. '

2016-05-09T14:10:42.972Z| svga| I120: WinBSOD: (30) `Dumping physical memory to disk: 0 '

+vmware.log(画面キャプチャ)

このように、仮想マシンで何か発生した際には、

vmware.logを見てみてください。

では、よい仮想化ライフを。