こんにちは。

今回はvSANクラスタの構成情報やログを見てみようの回です。

ログバンドルの収集方法については、以前のポストが参考になります。

【環境情報】

VMware ESXi 6.5.0 GA build-4564106(少し古くてすみません)

SSD1本のハイブリッド構成

取得したログを解凍すると、以下のディレクトリ構造になっています。

# ls

README action.log altbootbank bootbank commands error.log errors-ignored.log etc json lib64 proc scratch usr var vmfs

【vSAN構成を見る】

定番ですが、[commands]ディレクトリに移動します。

構成が書いている txt ファイルは主に以下の3つです。

・localcli_vsan-storage-list.txt

・localcli_vsan-cluster-get.txt

・localcli_vsan-network-list.txt

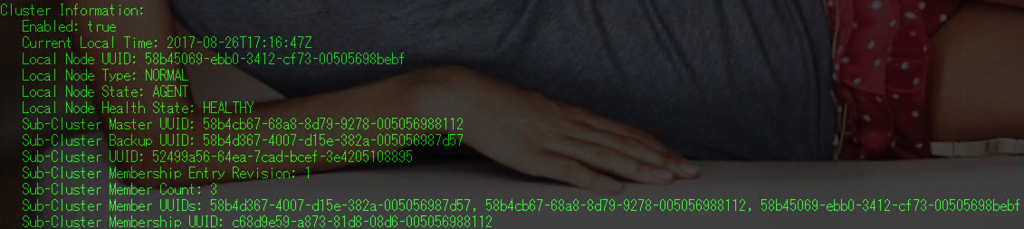

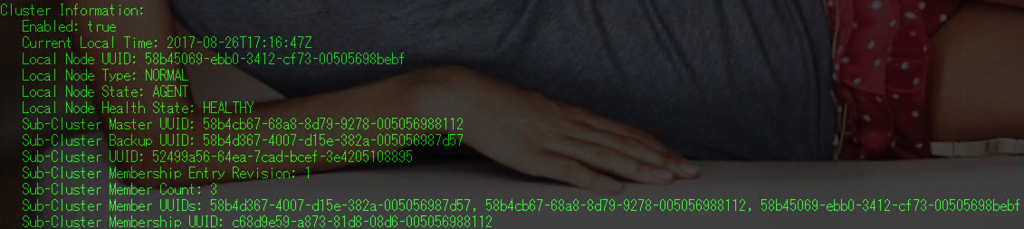

+ localcli_vsan-cluster-get.txtの中身

本当にクラスタの情報だけが載っています。

クラスタにどんなUUIDのメンバがいるか記載されています。

見づらいのでテキストでも貼ります。

============

Cluster Information:

Enabled: true

Current Local Time: 2017-08-26T17:16:47Z

Local Node UUID: 58b45069-ebb0-3412-cf73-00505698bebf

Local Node Type: NORMAL

Local Node State: AGENT

Local Node Health State: HEALTHY

Sub-Cluster Master UUID: 58b4cb67-68a8-8d79-9278-005056988112

Sub-Cluster Backup UUID: 58b4d367-4007-d15e-382a-005056987d57

Sub-Cluster UUID: 52499a56-64ea-7cad-bcef-3e4205108895

Sub-Cluster Membership Entry Revision: 1

Sub-Cluster Member Count: 3

Sub-Cluster Member UUIDs: 58b4d367-4007-d15e-382a-005056987d57, 58b4cb67-68a8-8d79-9278-005056988112, 58b45069-ebb0-3412-cf73-00505698bebf

Sub-Cluster Membership UUID: c68d9e59-a873-81d8-08d6-005056988112

============

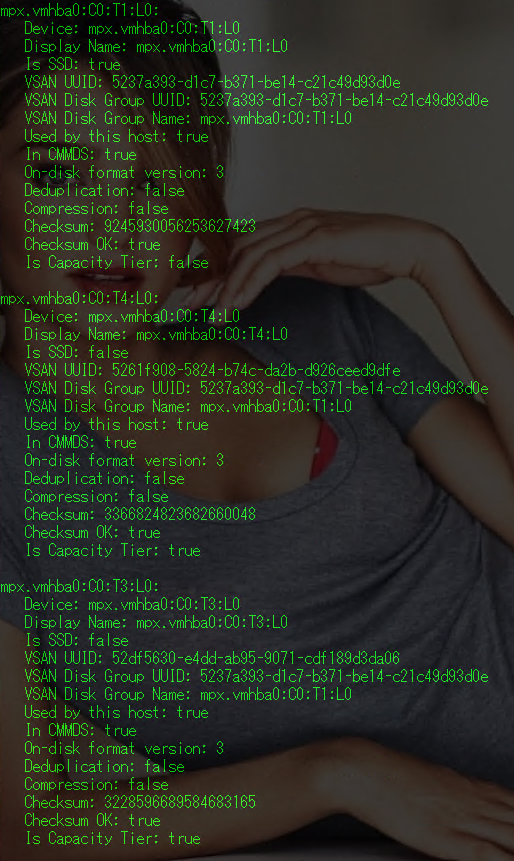

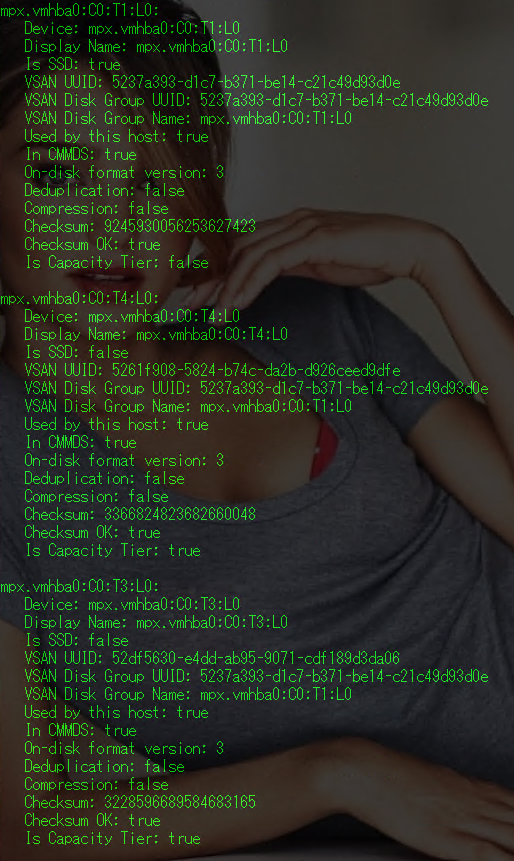

+ localcli_vsan-storage-list.txt の中身

vSANで使用中のローカルディスクの情報が出ます。

どのディスクグループに所属しているのか、も表示されます。

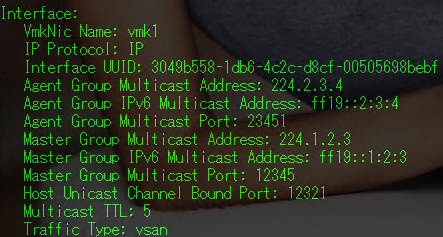

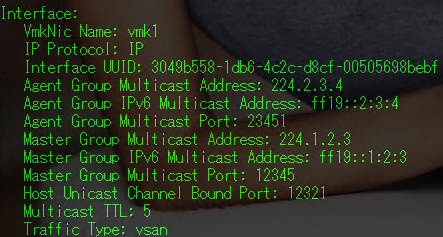

+localcli_vsan-network-list.txtの中身

(テキスト)

Interface:

VmkNic Name: vmk1

IP Protocol: IP

Interface UUID: 3049b558-1db6-4c2c-d8cf-00505698bebf

Agent Group Multicast Address: 224.2.3.4

Agent Group IPv6 Multicast Address: ff19::2:3:4

Agent Group Multicast Port: 23451

Master Group Multicast Address: 224.1.2.3

Master Group IPv6 Multicast Address: ff19::1:2:3

Master Group Multicast Port: 12345

Host Unicast Channel Bound Port: 12321

Multicast TTL: 5

Traffic Type: vsan

=============

vSANのHealth 状態を見たりする場合は以下の結果も見たりします。

・python_usrlibvmwarevsanbinvsan-health-statuspyc-base_info.txt

・python_usrlibvmwarevsanbinvsan-health-statuspyc-obj_info.txt

・python_usrlibvmwarevsanperfsvcvsan-perfsvc-statuspyc-svc_info.txt

大体これらの結果を見ることでvSANで使用しているディスクがどれなのか判別がつきます。

【vSANの動きを大まかに見るには】

vSANで何か問題が発生したときvSANの挙動をまずはおおまかに把握する必要があります。このファイルを見るといろいろわかります。

# <vm-support fileName>/var/run/log

FileName: vsansystem.log

例えば、新規にディスクグループを作成したときは、パーティションが作成されたことや、ディスクがフォーマットされる様子、ディスクグループの作成されたことがわかったりします。太字部分がそうです。

==================================■vsansystem.log

2017-08-27T09:43:34.491Z info vsansystem[4E41EFD700] [Originator@6876 sub=VsanPluginMgr opId=7d31c144-59-fd98] Checking 5 disks for uniqueness

2017-08-27T09:43:34.491Z info vsansystem[4E41EFD700] [Originator@6876 sub=VsanPluginMgr opId=7d31c144-59-fd98] Done checking disk uniqueness: OK

2017-08-27T09:43:34.491Z info vsansystem[4E41EFD700] [Originator@6876 sub=VsanPluginMgr opId=7d31c144-59-fd98] Done checking disk types: OK

2017-08-27T09:43:34.491Z warning vsansystem[4E41EFD700] [Originator@6876 sub=VsanPluginMgr opId=7d31c144-59-fd98] Get disks from Hostd. Note it should not be called with lock held

2017-08-27T09:43:34.491Z info vsansystem[4E41EFD700] [Originator@6876 sub=SimsHostdStub opId=7d31c144-59-fd98] Retrieve property from Hostd for vim.host.StorageSystem,storageSystem,storageDeviceInfo.

2017-08-27T09:43:34.505Z verbose vsansystem[4E41EFD700] [Originator@6876 sub=SimsHostdStub opId=7d31c144-59-fd98] Done Hostd property: vim.host.StorageSystem,storageSystem,storageDeviceInfo.Result:Not printed

2017-08-27T09:43:34.505Z info vsansystem[4E41EFD700] [Originator@6876 sub=VsanPluginMgr opId=7d31c144-59-fd98] Done checking for ineligible disks: OK

2017-08-27T09:43:34.505Z verbose vsansystem[4E41EFD700] [Originator@6876 sub=VsanPluginMgr opId=7d31c144-59-fd98] ValidateDiskMapping Complete

2017-08-27T09:43:34.505Z info vsansystem[4E41EFD700] [Originator@6876 sub=VsanPluginMgr opId=7d31c144-59-fd98] Formatting VSAN disks

2017-08-27T09:43:34.533Z info vsansystem[4E41EFD700] [Originator@6876 sub=Libs opId=7d31c144-59-fd98] VsanUtil: Successfully promoted node version.

2017-08-27T09:43:34.546Z info vsansystem[4E41EFD700] [Originator@6876 sub=Libs opId=7d31c144-59-fd98] VsanSysinfo: Loading module lsom

2017-08-27T09:43:34.547Z info vsansystem[4E41EFD700] [Originator@6876 sub=Libs opId=7d31c144-59-fd98] VsanInfoImpl: Creating disk-group with SSD: naa.44948575973cff5803286677d6b0720d

2017-08-27T09:43:34.675Z info vsansystem[4E41EFD700] [Originator@6876 sub=Libs opId=7d31c144-59-fd98] VsanDiskLunImpl: Device with 512 sector size.

2017-08-27T09:43:34.748Z info vsansystem[4E41EFD700] [Originator@6876 sub=Libs opId=7d31c144-59-fd98] VsanDiskLunImpl: Created partition for disk naa.44948575973cff5803286677d6b0720d ★(SSD)

2017-08-27T09:43:34.750Z info vsansystem[4E41EFD700] [Originator@6876 sub=Libs opId=7d31c144-59-fd98] VsanDiskLunImpl: Device with 512 sector size.

2017-08-27T09:43:34.894Z info vsansystem[4E41EFD700] [Originator@6876 sub=Libs opId=7d31c144-59-fd98] VsanDiskLunImpl: Created partition for disk naa.44948575973cf4ceececb6a756ede276 ★(Disk)

2017-08-27T09:43:34.895Z info vsansystem[4E41EFD700] [Originator@6876 sub=Libs opId=7d31c144-59-fd98] VsanDiskLunImpl: Device with 512 sector size.

2017-08-27T09:43:35.073Z info vsansystem[4E41EFD700] [Originator@6876 sub=Libs opId=7d31c144-59-fd98] VsanDiskLunImpl: Created partition for disk naa.48575973cf4c62d9168f994aab126cf0 ★(Disk)

2017-08-27T09:43:35.074Z info vsansystem[4E41EFD700] [Originator@6876 sub=Libs opId=7d31c144-59-fd98] VsanDiskLunImpl: Device with 512 sector size.

2017-08-27T09:43:35.227Z info vsansystem[4E41EFD700] [Originator@6876 sub=Libs opId=7d31c144-59-fd98] VsanDiskLunImpl: Created partition for disk naa.48575973cf4cb3d528e913d747423c56 ★(Disk)

2017-08-27T09:43:35.228Z info vsansystem[4E41EFD700] [Originator@6876 sub=Libs opId=7d31c144-59-fd98] VsanDiskLunImpl: Device with 512 sector size.

2017-08-27T09:43:35.361Z info vsansystem[4E41EFD700] [Originator@6876 sub=Libs opId=7d31c144-59-fd98] VsanDiskLunImpl: Created partition for disk naa.48575973cf4ccebe576f8704b2ab1e42 ★(Disk)

2017-08-27T09:43:35.362Z info vsansystem[4E41EFD700] [Originator@6876 sub=Libs opId=7d31c144-59-fd98] VsanDiskLunImpl: Formatting VSAN disk naa.44948575973cff5803286677d6b0720d

2017-08-27T09:43:35.365Z info vsansystem[4E41EFD700] [Originator@6876 sub=Libs opId=7d31c144-59-fd98] VsanDiskLunImpl: Read VSAN metadata for naa.44948575973cff5803286677d6b0720d

2017-08-27T09:44:27.730Z info vsansystem[4E41EFD700] [Originator@6876 sub=Libs opId=7d31c144-59-fd98] VsanDiskLunImpl: Formatting VSAN disk naa.44948575973cf4ceececb6a756ede276

2017-08-27T09:44:27.733Z info vsansystem[4E41EFD700] [Originator@6876 sub=Libs opId=7d31c144-59-fd98] VsanDiskLunImpl: Read VSAN metadata for naa.44948575973cff5803286677d6b0720d

2017-08-27T09:44:27.759Z info vsansystem[4E41EFD700] [Originator@6876 sub=Libs opId=7d31c144-59-fd98] VsanDiskLunImpl: Formatting VSAN disk naa.48575973cf4c62d9168f994aab126cf0

2017-08-27T09:44:27.787Z info vsansystem[4E41EFD700] [Originator@6876 sub=Libs opId=7d31c144-59-fd98] VsanDiskLunImpl: Formatting VSAN disk naa.48575973cf4cb3d528e913d747423c56

2017-08-27T09:44:27.812Z info vsansystem[4E41EFD700] [Originator@6876 sub=Libs opId=7d31c144-59-fd98] VsanDiskLunImpl: Formatting VSAN disk naa.48575973cf4ccebe576f8704b2ab1e42

2017-08-27T09:44:27.836Z info vsansystem[4E41EFD700] [Originator@6876 sub=Libs opId=7d31c144-59-fd98] VsanInfoImpl: VSAN clustering is enabled

==================================

【もっと詳細を調査する場合】

# <vm-support fileName>/var/run/log

・vsanmgmt.log

・vsanvpd.log

これらを見ることになります。

【感想】

vm-supportにはいろんな構成情報やログが含まれていますが、

まだvSANのログは少ない印象です。

終わり