ついこの間、Windows Server 2012 R2 で OS 再起動を実行後、

IP Address を固定に設定している環境でも、

169.254.x.x のアドレスに変わる事象に遭遇しました。

正直焦りました。

最初は同じネットワーク上に同じIP Address のマシンが存在するのか?

とか、いろいろ四苦八苦しましたが、そういうわけでもなく、違う要因でした。

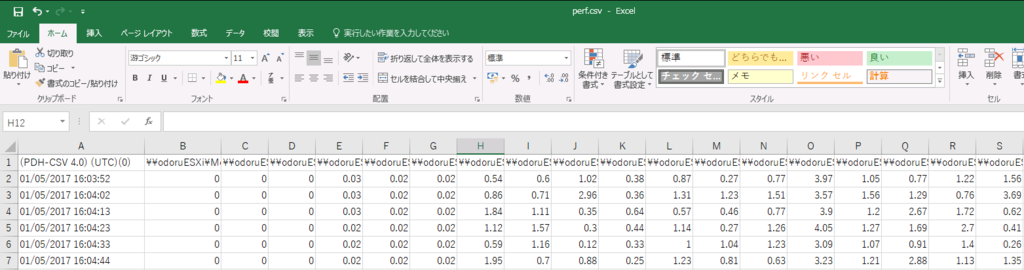

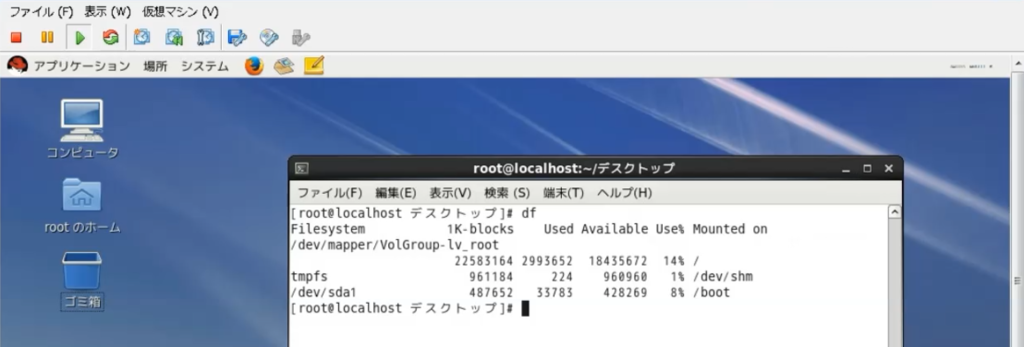

[Environment]

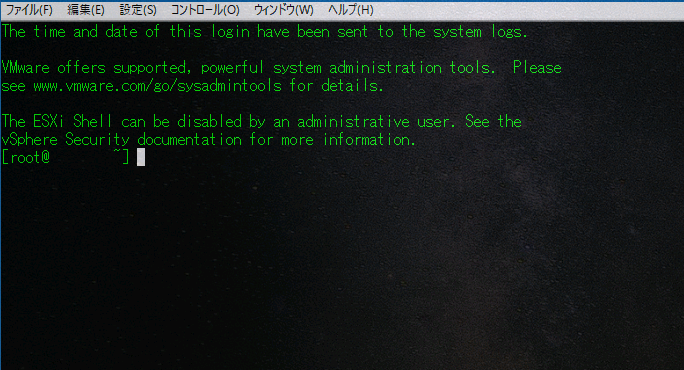

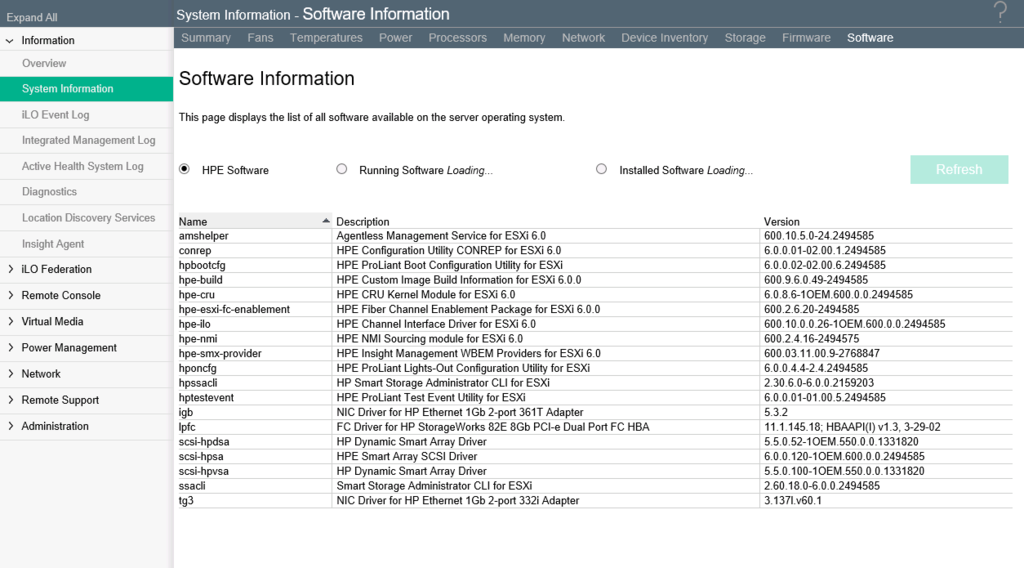

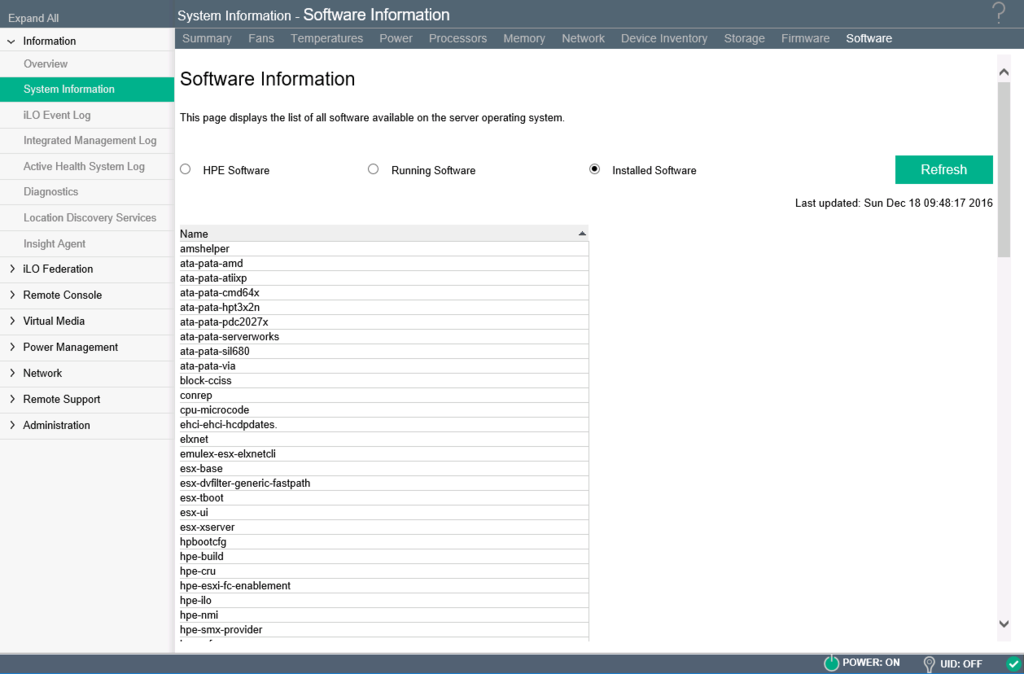

OS: ESXi5.5

Guest OS : Windows Server 2012 R2

+ 環境で Cisco デバイスを使用していると、ESX/ESXi 上の Microsoft Windows Vista 以降の仮想マシンで重複した IP アドレスが誤って検出される

https://kb.vmware.com/kb/2092679

+ False duplicate IP address detected on Microsoft Windows Vista and later virtual machines on ESX/ESXi when using Cisco devices on the environment (1028373)

https://kb.vmware.com/kb/1028373

VMware KB に記載の内容になりますが、事象は以下の内容です。

- Windows Vista 以降のバージョンで IP アドレスを割り当てるとき、重複した IP アドレスの競合が表示されます。

- Windows Vista 以降のバージョンを再起動すると、169.254.x.x の IP アドレスが割り当てられます。

- vSwitch 上のアップリンク ポートのない vSwitch 上に同じ仮想マシンをセットアップすると、IP アドレスは正常に割り当てられます。

- 同じ vSwitch 上の Windows 2003 仮想マシンに同じ IP アドレスを割り当てると、IP アドレスは正常に割り当てられます。

私が遭遇したとき、Windowsのイベントログに以下のような記録がありました。

◆システムログ

Tcpip 4199 なし IP アドレス xxx.xxx.xxx.xxx とシステムのネットワーク

ハードウェア アドレス XX-XX-XX-XX-XX-XX が 重複しているのを、検出しました。

このシステムのネットワーク操作は 無効になる可能性があります。

この記録で私はなんとかVMware KB 2092679 にたどり着けました。

Ciscoのスイッチに影響を受けるみたいなので、

単純にESXiのログだけみたり、事象だけを見ていると解決には時間がかかります。

少し視野を広げる必要があります。

Ciscoのスイッチに影響するようなので、ESXi上のゲスト以外にもHyper-V上のゲストでも、物理ホストでも発生すると思うので、なかなか注意したい内容でした。

[補足]

関連情報としては以下のようなものがありました。

False duplicate IP address detected on Microsoft Windows Vista and later virtual machines on ESX/ESXi when using Cisco devices on the environment (1028373)

https://kb.vmware.com/kb/1028373

Duplicate IP Address 0.0.0.0 Error Message Troubleshoot

http://www.cisco.com/c/en/us/support/docs/ios-nx-os-software/8021x/116529-problemsolution-product-00.html

日本語で情報を解説してくれている方もおられました。すごく有り難い。

http://rtaki.sakura.ne.jp/infra/?p=664

オワリ。